Сравнение производительности гипервизоров: хорошо это или плохо? Какой выбрать гипервизор

как это работает / Хабрахабр

Теория

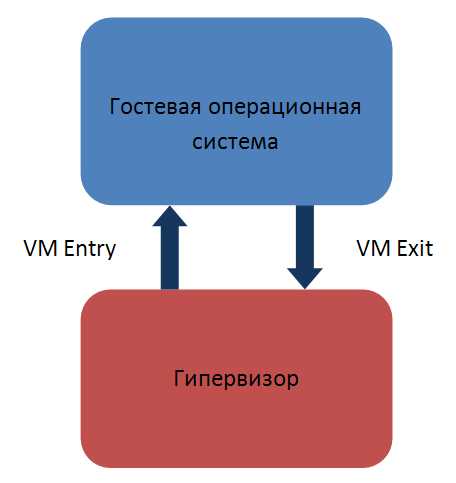

Итак, у нас есть гипервизор и работающая под его контролем гостевая операционная система (гость).

Переход управления из гипервизора в гостевую ОС называется VM Entry, обратный переход – VM Exit. Вся работа – это последовательность VM Entry и VM Exit, сменяющих друг друга. Гипервизор работает в изолированном адресном пространстве и «невидим» со стороны гостевой ОС. При этом он может изменять состояние гостевой ОС (виртуальный процессор, память, виртуальное аппаратное обеспечение и т.д.).

Читателю есть смысл ознакомиться с нашей предыдущей статьей, где речь шла о методе, основанном на теневой таблице страниц (shadow paging). Описываемый здесь метод – дальнейшее логическое его развитие.

Аппаратная виртуализация памяти, в противовес программной виртуализации в shadow paging, резко упрощает гипервизор и, как следствие, делает его надежнее. Кроме того, значительно повышается производительность и снижается расход памяти.

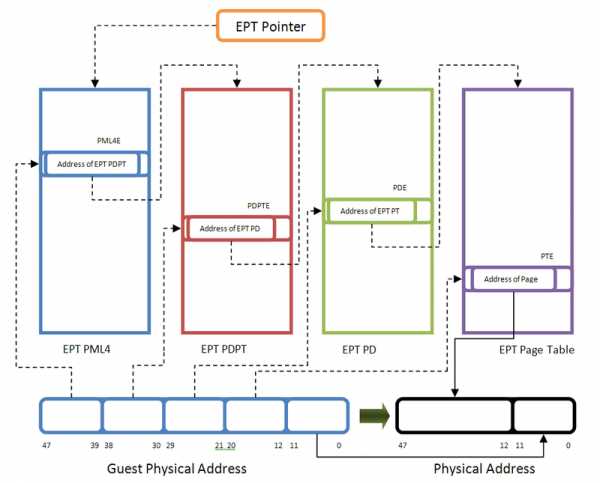

При обычной работе процессора любое обращение к физическому адресу немедленно ведет к его выставлению на адресной шине процессора (кроме таких случаев, как обращение к APIC, но мы их опустим для простоты изложения). В случае с nested paging любое обращение гостя к физическому адресу (он получает название «гостевой физический адрес») сперва транслируется через специальную таблицу страниц. Физический адрес, полученный из гостевого физического адреса, выставляется на адресной шине, после чего происходит обращение к памяти.

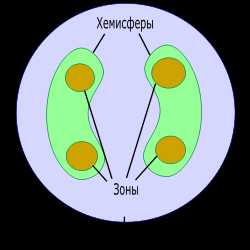

Преобразование гостевых физических адресов для Intel EPT аналогично обычному страничному преобразованию:

Таблица страниц четырехуровневая и напоминает таблицу страниц для преобразования виртуальных адресов в 64-битном режиме Intel 64. Основное отличие – строение записей таблицы. На рисунке приведено строение записи для нижнего уровня таблицы (PTE):

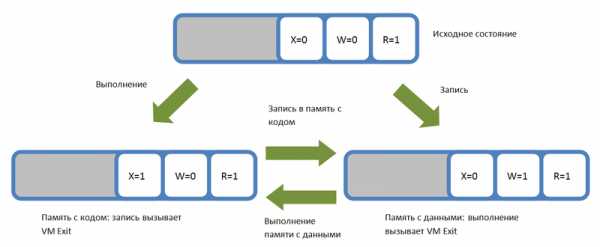

Нас интересуют три младших бита записей, которые определяют доступ к физической памяти. Если сброшены биты R, W, X (биты 0...2), то доступ к описываемой PTE памяти соответственно на чтение, запись и исполнение вызывает выход в гипервизор (EPT Violation по терминологии Intel).

Это дает возможность контролировать исполнение кода на процессоре и записи в память c кодом.

Суть метода

Полная виртуализация не является в нашем случае целью. Для контроля над выполнением и модификацией кода нам достаточно виртуализировать память и процессор.Далее возможны два варианта выхода в гипервизор (VM Exit) с EPT Violation:

- Доступ к странице памяти на запись. При этом происходит выход в гипервизор, после чего он разрешает запись в страницу (устанавливает бит W), но запрещает выполнение (сбрасывает бит X).

- Доступ к странице памяти на выполнение. При этом гипервизор разрешает выполнение на странице (устанавливает X), но запрещает запись в нее (сбрасывает W).

Таким образом, страница памяти может быть либо только исполняемой, либо только записываемой. Запись и исполнение соответственно влекут выход в гипервизор (VM Exit) и переводят страницу из одного состояния в другое.

Обрабатывая эти события, гипервизор может перехватывать запись в невыгружаемый код, а также выполнение вне пределов системных модулей. При наступлении каждого из событий можно анализировать код, вызвавший его.

Практическая реализация

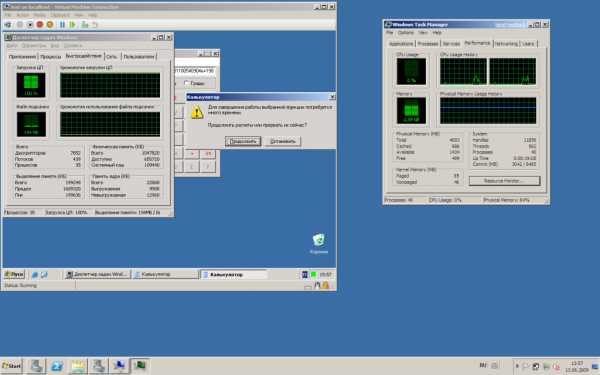

Мы реализовали детектор руткитов Hypersight Rootkit Detector, использующий вышеописанный метод. Он спроектирован так, чтобы его можно было загружать и выгружать по запросу пользователя. Это позволяет использовать его совместно с программами виртуализации, такими как VMware и VirtualBox.Наш детектор руткитов может обнаруживать следующую активность в ядре:

- Попытки перехода в режим гипервизора.

- Модификации управляющих регистров кодом вне ядра и HAL.

- Модификации невыгружаемого кода ядра, HAL и драйверов в памяти, модификации SSDT. В том числе модификации путем отображения виртуальной памяти.

- Выполнение кода за пределами исполняемых секций драйверов, ядра и HAL. Так называемый «скрытый код», козырная карта руткитов, теперь легко обнаруживается.

Дальнейшая работа

Возможности гипервизора не ограничиваются лишь детектированием руткитов. Возможно также и блокирование вредоносной активности. Мы ведем исследования в этой области и надеемся представить результаты в скором будущем. Также на повестке дня стоит портирование на 64-битную архитектуру и процессоры AMD RVI.Заключение

В последнее время антивирусные компании обратили внимание на гипервизоры и стали нанимать их разработчиков. Однако стоит заметить, что разработка гипервизора «с нуля» – достаточно трудоемкий и дорогостоящий процесс, несмотря на кажущуюся внешнюю простоту. Наша компания может предложить свой опыт в этой области, а также работающее решение.Литература

Документация по процессорам Intel: www.intel.com/content/www/us/en/processors/architectures-software-developer-manuals.htmlДокументация по процессорам AMD: developer.amd.com/documentation/guides/Pages/default.aspx

habr.com

Сравнение производительности гипервизоров: хорошо это или плохо?

Существует множество «зависимых» и независимых тестов, проводимых для выяснения чьи же яйца кто все-таки быстрее. Однако, болезнь «зависимых» тестов, проводимых производителем гипервизора, – их возможная пристрастность. Болезнь независимых – неготовность к сравнению такого рода.Например, на следующем рисунке вы можете видеть загрузку процессора для гостевой и родительской (хоста )операционных систем в Hyper-V R2. Пример №2 – программа для тестирования производительности HDD – HDTune. Я считал ее вполне адекватной, пока не установил на свой ноутбук Sun VirtualBox. Показанная мне скорость (виртуального) жесткого диска превышала физическую в три раза.Другая ошибка, которую часто допускают при сравнении гипервизоров – неверные предпосылки. Как правило, авторы выбирают изолированный (standalone) хост для тестирования производительности с помощью как синтетических, так и реальных нагрузок. Планируется, что результаты теста будут очень интересовать клиентов из малого или среднего бизнеса, поскольку для уровня Enterprise более интересен именно функционал гипервизора. Так ли это?Допустим, я средний заказчик, имеющий 20 Windows Server на отдельных физических серверах и примерно 500 клиентских машин. Я думаю, что в 90% случаев такому заказчику вполне хватит трех физических серверов с двумя 4-ядерными процессорами Intel Xeon, 32 (если не 16) гигабайтами оперативной памяти и полки на двенадцать SAS-дисков 15k. Причем я вполне смогу выбрать для себя любой из гипервизоров и успешно реализовать на нем консолидацию серверов. По сути, выбор гипервизора в таких компаниях зачастую зависит от предпочтений системного администратора либо того, кто первым найдет общий язык с директором по ИТ. В результате мы видим, что для малого бизнеса функционал, как ни странно, важнее, чем большая производительность гипервизора.В то же время, крупным заказчикам жизненно необходимы такие технологии, как vMotion или Fault Tolerance. Необходимы, пожалуй, в большей степени чем большая производительность. Получается, что всем нужны технологии, а сравнивается обычно производительность 🙂Сравнивать гипервизоры по технологиям тоже не совсем корректно. Возьмем в пример тот же High Availability (высокая доступность виртуальных машин). Решение, доступное в бесплатном Hyper-V Server R2 и в платных Xen/vSphere. При этом, коллега Leo из солнечной Австралии делится, как настроить High Availability на БЕСПЛАТНЫХ ESXi.Давайте сравним Live Migration (перенос виртуальной машины на другой хост без ее остановки), который будет у Microsoft и уже есть у Citrix, VMware. Не буду говорить за Citrix, но у Microsoft есть значительное ограничение – хост может участвовать только в одном процессе Live Migration одновременно. Если у вас на хосте 30 виртуальных машин, процесс миграции затянется.Получается, производительность вообще никому не нужна, так? Нет не так. Например, Михаил Михеев приводит пример банка, консолидировавшего большую часть своих серверов. Его виртуальные машины генерируют нагрузку примерно в 30000 IOPS. Пусть я покажусь неграмотным, но представим, что каждая операция чтения/записи использует кусок данных в 16 килобайт. Требуемая пропускная способность в этом случае примерно 3,67 гигабит/сек. Как вы понимаете, еще нужно протестировать, какие гипервизоры и на каком оборудовании смогут выдавать столько IOPS.Другой пример – все хорошие функции платные и лицензируются либо по процессорам, либо по хостам. При лицензировании гостевых операционных систем Windows Server есть интересная возможность – покупая на физический сервер Windows Server Datacenter, вы можете запускать в виртуальной среде неограниченное количество виртуальных серверов. Соответственно, если у вас 600 виртуальных машин с Windows Server, то для вас есть разница, покупаете вы лицензии на 20 хостов или на 30. Даже если это 20 хостов vSphere Enterprise Plus или 30 хостов с XenServer Essentials, например (в обоих случаях рассматриваются 2-процессорные сервера). Кстати, в приведенном примере гипервизор VMware вроде бы получается дороже по лицензиям примерно на $16000. Но в итоге может оказаться дешевле за счет меньшего количества серверов!Какие же выводы можно сделать? Производительность важнее все-таки для средних/крупных клиентов. Мелким же интересен максимум функционала за минимум денег или лучшее соотношение цены/качества. А качественно сравнить функционал — это вам не попугаев мерить!

Пример №2 – программа для тестирования производительности HDD – HDTune. Я считал ее вполне адекватной, пока не установил на свой ноутбук Sun VirtualBox. Показанная мне скорость (виртуального) жесткого диска превышала физическую в три раза.Другая ошибка, которую часто допускают при сравнении гипервизоров – неверные предпосылки. Как правило, авторы выбирают изолированный (standalone) хост для тестирования производительности с помощью как синтетических, так и реальных нагрузок. Планируется, что результаты теста будут очень интересовать клиентов из малого или среднего бизнеса, поскольку для уровня Enterprise более интересен именно функционал гипервизора. Так ли это?Допустим, я средний заказчик, имеющий 20 Windows Server на отдельных физических серверах и примерно 500 клиентских машин. Я думаю, что в 90% случаев такому заказчику вполне хватит трех физических серверов с двумя 4-ядерными процессорами Intel Xeon, 32 (если не 16) гигабайтами оперативной памяти и полки на двенадцать SAS-дисков 15k. Причем я вполне смогу выбрать для себя любой из гипервизоров и успешно реализовать на нем консолидацию серверов. По сути, выбор гипервизора в таких компаниях зачастую зависит от предпочтений системного администратора либо того, кто первым найдет общий язык с директором по ИТ. В результате мы видим, что для малого бизнеса функционал, как ни странно, важнее, чем большая производительность гипервизора.В то же время, крупным заказчикам жизненно необходимы такие технологии, как vMotion или Fault Tolerance. Необходимы, пожалуй, в большей степени чем большая производительность. Получается, что всем нужны технологии, а сравнивается обычно производительность 🙂Сравнивать гипервизоры по технологиям тоже не совсем корректно. Возьмем в пример тот же High Availability (высокая доступность виртуальных машин). Решение, доступное в бесплатном Hyper-V Server R2 и в платных Xen/vSphere. При этом, коллега Leo из солнечной Австралии делится, как настроить High Availability на БЕСПЛАТНЫХ ESXi.Давайте сравним Live Migration (перенос виртуальной машины на другой хост без ее остановки), который будет у Microsoft и уже есть у Citrix, VMware. Не буду говорить за Citrix, но у Microsoft есть значительное ограничение – хост может участвовать только в одном процессе Live Migration одновременно. Если у вас на хосте 30 виртуальных машин, процесс миграции затянется.Получается, производительность вообще никому не нужна, так? Нет не так. Например, Михаил Михеев приводит пример банка, консолидировавшего большую часть своих серверов. Его виртуальные машины генерируют нагрузку примерно в 30000 IOPS. Пусть я покажусь неграмотным, но представим, что каждая операция чтения/записи использует кусок данных в 16 килобайт. Требуемая пропускная способность в этом случае примерно 3,67 гигабит/сек. Как вы понимаете, еще нужно протестировать, какие гипервизоры и на каком оборудовании смогут выдавать столько IOPS.Другой пример – все хорошие функции платные и лицензируются либо по процессорам, либо по хостам. При лицензировании гостевых операционных систем Windows Server есть интересная возможность – покупая на физический сервер Windows Server Datacenter, вы можете запускать в виртуальной среде неограниченное количество виртуальных серверов. Соответственно, если у вас 600 виртуальных машин с Windows Server, то для вас есть разница, покупаете вы лицензии на 20 хостов или на 30. Даже если это 20 хостов vSphere Enterprise Plus или 30 хостов с XenServer Essentials, например (в обоих случаях рассматриваются 2-процессорные сервера). Кстати, в приведенном примере гипервизор VMware вроде бы получается дороже по лицензиям примерно на $16000. Но в итоге может оказаться дешевле за счет меньшего количества серверов!Какие же выводы можно сделать? Производительность важнее все-таки для средних/крупных клиентов. Мелким же интересен максимум функционала за минимум денег или лучшее соотношение цены/качества. А качественно сравнить функционал — это вам не попугаев мерить!

vmind.ru

Выбираем гипервизор

Задача

В один из моментов развития компания появилась задача одновременного поднятия пяти различных серверов с различным набором приложений и различными ОС. Какие то сервера уже существовали до этого момента, какие то ставились с нуля в силу необходимости, факт оставался фактом, сервера - нужны, и причем сервера которые судя по всему в ближайшее время нагружены очень сильно по современным меркам не будут. Имеем два варианта выбора: купить 5 недорогих rack/tower серверов или купить один производительный сервер, установить на него гипервизор и поднять под ним сервера. Пришли к выводу что экономически целесообразнее второй вариант:Теперь решаем задачу какой гипервизор использовать. Для этого взяли три известных продукта: Citrix XenServer 6.0, VMware ESXi 5.0, Hyper-V Server 2008 R2 и протестировали их с помощью трех ОС:Все продукты тестировались как есть, без тюнинга систем и сборки узкозаточенных ядер. Задача стояла в том, чтобы выяснить какой продукт для нас предпочтительнее использовать, тонкие настройки и прочее будут позже. Мы не агитируем за использование того или иного решения, но настаиваем, чтобы когда вы делали свой выбор, вы прошли эти шаги сами и со своими условиями. Тесты не особо трудозатратные, требуют только определенного запаса во времени. Все продукты, в том числе и гипервизоры АБСОЛЮТНО БЕСПЛАТНЫ как для тестирования, так и для использования.- Сервер: DL160

- Гипервизоры:Citrix XenServer 6.0, VMware ESXi 5.0, Hyper-V Server 2008 R2

- ОС: Linux Fedora 15, FreeBSD 8.2 i386, FreeBSD 8.2 amd64

- Тестовая программа: UnixBench 5

- Каждой гостевой системе выделялось: 2 процессорных ядра, 1 ГБ оперативной памяти, 100 ГБ дискового пространства

FreeBSD 8.2 amd64

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

FreeBSD 8.2 i386

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Linux Fedora 15

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Выводы:

Выводы для себя каждый сделает сам в зависимости от задачи, конкретно нам были интересны тесты в большей степени Dhrystone/Whetstone и скорости межпроцессного сообщения, свой выбор мы сделали. Подробнее о том что из себя представляет каждый тест описано тут: byte-unixbench и CSA. Из явных плюсов сразу бросающихся в глаза хотелось бы отметить: Citrix XEN - очень простая и удобная работа с NFS хранилищами, ESXi - удобный и информативный интерфейс управления и мониторинга, и огромный плюс Hyper-V - failover "из коробки и бесплатно", правда для этого придется поднимать контроллер домена если у вас его нету.www.jitsys.ru

Что такое виртуализация, гипервизр, VMWare ESXi/Hypervisor - и как начать работать

Опубликовано ISSystems.kz

Виртуализация — "процесс представления вычислительных ресурсов, который позволяет абстрагироваться от их конкретной реализации, географического положения или физической конфигурацией составных частей".

Гипервизор ( например, VMWare ESXi, VMware Hypervisor, Microsoft Hyper-V ) - такая хитрая прослойка между «железом» сервера ( аппаратным уровнем ) и уровнем операционых систем. Гипервизор обычно инсталлируется на голое железо сервера ( в этом случае он называется «bare metal»), а для операционных систем ( они в этом случае называются гостевыми ) эмулирует доступ к аппаратному серверу.

Бывают гипервизоры, которые работают как приложение на обычной операционной системе ( в этом случае он называется "hosted" и прослойка получается совсем не тонкая, а очень толстая, и виртуальные машины работают уже не на втором уровне, а на третьем от железа ).

На одном физическом сервере можно запустить несколько гостевых ОС. Виртуальные ресурсы, которые гипервизор предоставляет гостевой ОС вместе с этой самой гостевой ОС назовём виртуальным сервером.

Каждая гостевая ОС виртуализированного сервера будет считать что она одна такая, и никак не будет связана с другими виртуальными серверами, которые «крутятся» на том же физическом сервере ( кроме, естественно, как через Ethernet сеть ).

Гостевая ОС никак не сможет определить, работает ли она на физическом железе или на виртуальном ( кроме как по разбору МАК-адресов и ID устройств ).

Никаких изменений в коде гостевой операционной системы нет. Клиент, удалённо подключающийся к серверу, тоже никак не определит – работает ли он с физическим или с виртуальным сервером.

Преимуществ у такого подхода ( виртуализации ) масса.

Например, ( «лежит на поверхности») , экономия на железе. Существует множество приложений, которые требуют под себя отдельный сервер ( не могут работать совместно с другими приложениями ), но при этом не загружают ресурсы сервера полностью ( VMWare называет цифру использования ресурсов 5-15% ) => можно на 1 физическом сервере разместить 5-10 виртуальных серверов.

Одновременное использование Linux, Windows и еще множества других ОС на одном физическом сервере.Решается проблема с устаревшими приложениями ( legacy applications ).

Поскольку получается, что «виртуальная машина» - это некий набор файлов, лежащий на диске, а гипервизоры, работающие на физическом железе предоставляют в виртуальное использование одинаковое «виртуальное железо», то отсюда следует далеко идущий вывод - следующее ( важнейшее ) преимущество:

Происходит полная «отвязка» от железа.- Если виртуальная машина – это «папка» файловой системы, то backup сервера превращается в копирование папки.- Если какому-то виртуальному серверу потребовалось больше ресурсов ( процессора, памяти, дисков ) – то для этого становится достаточным переместить мышкой ползунок.- Если же недостаточно ресурсов физического сервера – происходит простое копирование этой виртуальной машины на более мощное железо с гипервизором, и виртуальная машина поднимается на новом физическом железе, как на родном.- в случае полного выхода из строя аппаратного сервера поднять все сервисы на другом становится минутным делом.

И т.д. и т.п. –На основе этого фундамента – гипервизора – компания VMWare построила целое здание.

Теперь есть возможность- перемещать виртуальные машины между физическими серверами «на горячую», т.е. без перерыва в обслуживании- автоматически перераспределять ВМ между серверами по расписанию или по нагрузке- автоматически “поднимать” и “гасить” виртуальные машины, например, вслучае выхода из строя физического сервера- автоматически «гасить» ( например на ночь ) часть физических серверов с переносом виртуальных машин на другие физические серверы- организовывать кластеры ( fault tolerance ) для обеспечения непрерывности бизнеса- автоматически предоставлять виртуальные машины разработчикам без участия ИТИ т.п.

У VMWare есть конвертор, который умеет преобразовывать ( переносить ) ряд операционных систем, инсталлированных на физическом железе – в виртуальные машины.

Кроме серверов, VMWare аналогичным образом умеет виртуализировать системы хранения данных ( storage ), сети ( virtual network ).

Всё это у VMWare входит в линейку продуктов Vsphere. Эти функции и множество других покрываются различными продуктами из линейки vSphere – vCenter, vMotion, и т.п. ( см. http://www.vmware.com/ru/products/ ).

Продукты сгруппированы в выпуски, подходящие для предприятий различного размера –От VMware vSphere Essentials - до VMware vSphere Enterprise PlusСм. Подробнее тут - http://www.vmware.com/ru/products/vsphere/editions.html

На основе виртуализированных дата-центров можно строить "облачные" инфраструктуры - частные, общественные или гибридные облака. Инструмент VMware для построения и управления облачными инфраструктурами - VMware vCloud.

Вообще абсолютно всеми продуктами VMWare можно воспользоваться в триальном режиме ( 60 дней с полным функционалом ), зарегистрировавшись и скачав их с сайта. При скачивании они там дают ( показывают ) ключи, которые понадобятся для тральной активизации продукта. Позже, если клиент примет решение о покупке, достаточно будет ввести купленный ключ, сохранив все настройки продукта. Триальный ключ клиенту может предоставить партнёр.

На сайте VMWare очень хорошо расписаны основы виртуализации - http://www.vmware.com/ru/virtualization/

Подробнее о гипервизоре ESXi – тут - http://www.vmware.com/products/esxi/

Управлять гипервизорами ESX можно с помощью бесплатного ПО «VMware vSphere Client», его можно скачать по ссылке с установленного гипервизора.

Как устанавливать ESXi, как настраивать и как им управлять – хорошо расписано тут – http://www.vmgu.ru/articles/vmware-esxi-4-vsphere-setup.

Ещё к продуктам VMWare существует множество платных и бесплатных дополнений/утилит сторонних расзработчиков.

Например, бесплатные можно посмотреть тут - http://www.vmgu.ru/articles/vmware-vsphere-esx-free-4.

Думаю, этого достаточно для начала работы с VMWare ESXi.В дальнейшем, если у вас появятся дополнительные вопросы, мы, как сертифицированные специалисты по VMWare, постараемся ответить на них.

Обращайтесь.

www.issystems.kz