Создание виртуальной машины с Hyper-V Server. Hyper v для чего нужен

Hyper-V — дитя маркетинга или реальная альтернатива? / Блог компании Microsoft / Хабр

Передаю слово автору.

Дисклеймер:

- Данная статья носит информативный характер и не преследует желание похайпить, а просто желание поделиться своей историей, которая, возможно, будет кому-нибудь полезна. Некоторые вещи сугубо индивидуальны, а суждения — личные.

- Нет, я не продался МS. Я просто долго искал статьи подобного плана как пищу для размышлений, но их не было. Пришлось делать самому.

- Блог МS — у меня нет инвайта, а товарищам идея статьи понравилась, и они предложили ее выложить.

- PR-а продукта не будет, будет рассказ про живое тестирование/внедрение.

А теперь у нас есть (ну практически есть) космический ядерный двигатель, план полететь на Марс в 2024 году и спутник за пределами нашей солнечной системы.

Так, собственно, к чему я это все веду. Это я к тому, что все это стало возможным благодаря (или вопреки) стремительно развивающимся компьютерным технологиям. Об одной из таких технологий сейчас и поговорим.

Эпиграф

Жила была одна компания. Ни большая, ни маленькая, ни высокая, ни низкая. Такой прям вылитый средний бизнес. Жила она себе с несколькими стойками оборудования, старого, от матери доставшегося. И наступил момент все это хозяйство обновлять. Посчитали товарищи стоимость оборудования, подумали, да надумали внедрять виртуализацию. А год был давний, из представителей славного рода универсальных виртуализаций только VMWare и была. В общем ее и внедрили. Шло время, менялись задачи, росли другие представители славного рода виртуализации. И пришло время снова выбирать себе представителя…

Главный вопрос ИТ-профессионала – «Зачем?»

(или «А нафига?»)

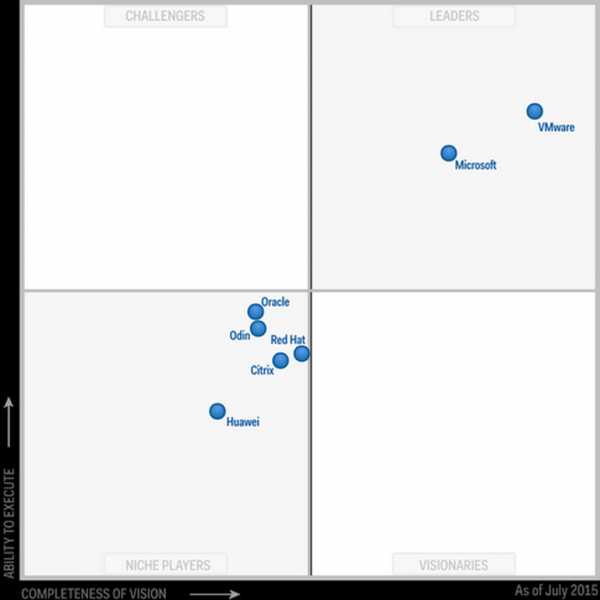

Позвольте представиться. Меня зовут Антон и я руковожу отделом инфраструктурных решений в одном их крупных российских ретейлеров. Как и в любой уважающей себя организации у нас используется виртуализация и, конечно же, наша всеми «любимая» 1С. Внедряли мы VMware давно, жили с ней, в принципе, неплохо (хотя историй добавивших мне седых волос тоже хватает), но, как и при любом развитии периодически приходится осматриваться вокруг, чтобы узнавать об альтернативных решениях.А началась наша история перехода с того, что я увидел Hyper-V в одном углу вместе с VMware у квадранта Gartner. Тут-то я и призадумался. По итогу раздумий получилась вот такая табличка «за/против» перехода. А еще знаменитые косяки VMware с CBT… Прямо мнямка. Да еще и два раза в двух разных релизах. Прям огонь!

«Как узнать, что человек ярый веган. Никак. Он сам вам об этом расскажет.» Так же и тут — как узнать ярого красноглазика. Никак. Он сам расскажет, что Linux — это божья благодать, а Windows — порождение князя тьмы.

Хейтеры 2x354 тут же встанут в стойку и, брызгая жидкостями, начнут рассказывать, как обновления Microsoft ломают к чертям вообще всю ОС. Это да, тут спорить не буду, есть у товарищей любовь к таким вот веселым подарочкам. Но в целом, процесс эволюции на мой взгляд у компании Microsoft доведен до совершенства. Революция — это не их, а вот эволюция — конек. И каждый выбирает то, что ему ближе.

Сразу оговорюсь — сравнение «by feature» тоже было, только в жизни никто «в здравом уме и крепкой памяти» не будет строить кластера по предельным значениям. Да и похожи они на самом деле практически как братья близнецы, а принципиальной разницы между тем, сколько сотен ядер можно отдать одной виртуальной машине я лично не вижу.Минута холивараПочему «Killer feature» от VMware во многом просто маркетинг?Проброс USB и PCI-девайсов. Тоже очень спорный момент. Эти вещи лишают виртуалку основного преимущества виртуализации — свободной миграции между хостами. Проброс PCI мы использовали, но как только смогли отказаться — облегченно выдохнули. Для проброса USB уже давным-давно придуманы и сделаны как софтовые, так и аппаратные решения. Сильно проще.

Кэширование данных на чтение на локальные SSD. Да, когда вышла очень радовался этой возможности. Но в реальности прирост не увидел даже на синтетических данных. А в рабочей среде периодически ловил дикие зависания этой системы (тут я не утверждаю, что вина системы —возможно это мои кривые руки что-то не так настроили). И вишенка на торте: кэширует эта система только блоки определенного размера, и надо потратить много времени на сбор информации о размере запроса к диску, думать какая именно виртуалка должна быть приоритетна в использовании этой технологии.

Зато у Hyper-V есть штатная возможность уменьшить диск. Знаете, сколько раз я мечтал о таком в VMware? Гораздо больше чем можно себе это представить.

- У вас основная ОС на Linux-серверах.

- Вам нужно запускать экзотику.

- Вам нужны готовые виртуальные сервера от вендеров (думаю это просто вопрос времени).

- Вы не любите Microsoft.

- VMware вы получили на халяву вместе с оборудованием.

Табличка размышлений

| Сокращение расходов на лицензии VMware | Известность платформы VMware |

| На базе этой же платформы построен Azure | Размер дистрибутива (спойлер: Nano Server не является аналогом esxi — это немного другая идеология и позиционирование) |

| Интересная сетевая виртуализация | Простая схема лицензирования |

| Репликация на другие СХД виртуалок штатными методами | Поддержка большого числа разных ОС |

| Бонусы при покупке комплекта для построения виртуализации (набор CIS, в который входят Windows Datacenter + System Center) | VMware уже работает |

| Различные плюшки при разворачивании Windows-серверов | Нет поддержки именно гипервизора как отдельного продукта |

| Можно уменьшать диски на лету | VDI тут можно использовать только для лабы/тестов. Для продакшена это не подходит |

| Более оперативная поддержка новых версий Windows | Наличие интересных законченных решений для виртуализации, когда ты у одного вендора покупаешь и железо и софт, и получаешь одну консоль управления и одно окно техподдержки |

| Это Microsoft | Это Microsoft |

«Прыжок веры»

Думал и гадал бы я еще долго, но тут сошлись звезды, и мы обновили парк серверов. А старые остались, причем неплохие, только уже медленные по нынешним меркам и к тому же морально устаревшие. И было принято стратегическое решение сделать ферму для разработки на базе Hyper-V. Перетащили сервера на новую площадку, обновили все прошивки серверов и понеслась.- Берем сервер.

- Устанавливаем на него esxi. Ничего не меняем, настройки по умолчанию.

- Разворачиваем виртуальную машину.

- Производим тесты 5 раз:

a) Для 1С тест Гилева.

b) Для SQL — скрипт на запись.

- Настраиваем по Best Practice’s.

- Производим тесты 5 раз:

a) Для 1С тест Гилева.

b) Для SQL — скрипт на запись.

- Устанавливаем Hyper-V. Ничего не меняем, настройки по умолчанию.

- Разворачиваем виртуальную машину.

- Производим тесты 5 раз:

a) Для 1С тест Гилева.

b) Для SQL — скрипт на запись.

- Настраиваем по Best Practice’s.

- Производим тесты 5 раз:

a) Для 1С тест Гилева.

b) Для SQL — скрипт на запись.

- Ставим на физическую машину Windows Server, настраиваем по Best Practice’s и проводим тесты.

- Сравниваем и думаем.

| 1 | 22.42 | 12.2 |

| 2 | 18.6 | 17.51 |

| 3 | 18.12 | 7.12 |

| 4 | 26.74 | 7.18 |

| 5 | 26.32 | 4.22 |

| VMWare с Best Practices | Тест Гилева | Тест SQL |

| 1 | 26.46 | 4.28 |

| 2 | 26.6 | 6.38 |

| 3 | 26.46 | 4.22 |

| 4 | 6.56 | |

| 5 | 26.6 | 4.2 |

| HyperV без Best Practices | Тест Гилева | Тест SQL |

| 1 | 27.17 | 4.32 |

| 2 | 26.46 | 6.08 |

| 3 | 26.04 | 4.24 |

| 4 | 26.18 | 5.58 |

| 5 | 25.91 | 6.01 |

| HyperV с Best Practices | Тест Гилева | Тест SQL |

| 1 | 26.18 | 6.02 |

| 2 | 27.62 | 6.04 |

| 3 | 26.46 | 6.2 |

| 4 | 26.74 | 4.23 |

| 5 | 26.74 | 6.02 |

| Физика | Тест Гилева | Тест SQL |

| 1 | 35.97 | 4.06 |

| 2 | 32.47 | 4.04 |

| 3 | 31.85 | 6.14 |

| 4 | 32.47 | 5.55 |

| 5 | 32.89 | 5.43 |

Легенда

Тест Гилева — больше значит лучше, абстрактные «попугаи».Тест SQL — меньше значит лучше, время исполнения.

Что настраивали:

1. Шаги по подготовке хоста DELL Poweredge 630.

1.1. Настраиваем хост по рекомендациям от DELL

1.1.1. Включить Processor Settings -> Virtualization Technology — включено.

1.1.2. Включить Processor Settings -> Logical Processor — включено.

1.1.3. Включить System Profile Settings -> Turbo Boost (в документации Turbo Mode) — включено.

1.1.4. Отключить Memory Setting -> Node Interleaving (включает NUMA) — отключено.

1.1.5. Включить Power Management -> Maximum Performance — похоже включено.

1.1.6. Отключить ненужные девайсы в Integrated Devices — не трогал.

1.1.7. Отключить System Profile Settings -> С1E — отключено.

1.1.8. Включить Processor Settings -> Hardware Prefetcher — включено.

1.1.9. Включить Processor Settings -> Adjacent Cache Line Prefetch — включено.

1.1.10. Включить Processor Settings -> DCU Streamer Prefetcher — включено.

1.1.11. Включить Processor Settings -> Data Reuse — не нашел.

1.1.12. Включить Processor Settings -> DRAM Prefetcher — не нашел.

1.2 Настраиваем хост по рекомендации

1.2.1 Настроить Fibre Chanel HBA.

1.2.1.1 При загрузке хоста зайти в QLogic Fast!UTIL (CTRL+Q).

1.2.1.2 Выбрать первый порт.

1.2.1.3 Сбросить настройки Configuration Settings -> Restore Default Settings.

1.2.1.4 Включить Configuration Settings -> Adapter Settings -> Host Adapter BIOS -> Host Adapter BIOS -> Enable.

1.2.1.5 Включить Configuration Settings -> Adapter Settings -> Host Adapter BIOS -> Connection Options -> 1.

1.2.1.6 Включить Configuration Settings -> Advanced Adapter Settings -> Enable LIP Reset -> Yes.

1.2.1.7 Включить Configuration Settings -> Advanced Adapter Settings -> Enable LIP Full Login -> Yes.

1.2.1.8 Включить Configuration Settings -> Advanced Adapter Settings -> Login Retry Count -> 60.

1.2.1.9 Включить Configuration Settings -> Advanced Adapter Settings -> Port Down Retry Count -> 60.

1.2.1.10 Включить Configuration Settings -> Advanced Adapter Settings -> Link Down Timeout -> 30.

1.2.1.11 Настроить второй порт по пунктам 1.2.1.3 – 1.2.1.10.

2. Шаги по тестированию на платформе VMware без best practices.

2.1 Устанавливаем VMware 5.5 со всеми апдейтами.

2.2 Делаем необходимые настройки на VMware (в кластер не включаем, тестим отдельно).

2.3 Устанавливаем Windows 2016 и все обновления.

2.4 Устанавливаем «1С: Предприятие». Настраиваем, если нужно пока ставим по дефолту, версия 1С — 8.3.10. (последняя).

2.5 На отдельной машине устанавливаем Windows 2016 с сервером SQL 2016 — со всеми апдейтами.

2.6 Проводим тесты (5 раз).

3. Шаги по тестированию на платформе VMware по best practices.

3.1.1 Поместить swap-файл на SSD диск. Cluster -> Swap file location -> Store the swap file in the same directory as VM. Configuration -> VM Swapfile location -> Edit.

3.1.2 Рекомендуется включить vSphere Flash Infrastructure layer – не знаю, насколько это реализуемо в наших реалиях.

3.1.3 Настроить SAN Multipathing через Host -> Configuration -> Storage -> Manage Paths -> Path Selection -> Round Robin.

3.1.4 Включить Host -> Configuration -> Power management -> Properties -> High Perfomance.

3.2 Настраиваем VM согласно рекомендациям:

3.2.1 Используем paravirtual диски: VM -> SCSI Controller -> Change Type -> Paravirtual.

3.2.2 Желательно использовать Thick provision eager zeroed.

3.2.3 Включаем VM -> Options -> CPU/MMU Virtualization -> Use Intel VTx for instruction set and Intel EPT for MMU Virtualization.

3.2.4 Отключаем VM BIOS -> Legacy diskette, VM BIOS -> Primary Mater CD ROM.

4. Шаги по тестированию на платформе Windows Server без best practices:

4.1 Устанавливаем Windows Server 2016 Datacenter на хост и все обновления.

4.2 Делаем необходимые настройки на хосте.

4.3 Устанавливаем виртуальную машину с Windows и все обновления.

4.4 Устанавливаем «1С: Предприятие». Настраиваем, если нужно пока ставим по дефолту, версия 1С — 8.3.10 (последняя).

4.5 На отдельной машине устанавливаем Windows Server 2016 с сервером SQL 2016 со всеми апдейтами.

5. Шаги по тестированию на платформе Windows Server по best practicesBest practices изложены тут, тут и тут.

5.1 Настраиваем Host согласно рекомендациям:

5.1.1 Активировать MPIO: Enable-WindowsOptionalFeature – Online – FeatureName MultiPathIO (Get-WindowsOptionalFeature – Online – FeatureName "MultiPathIO").State

5.2 Настраиваем VM согласно рекомендациям:

5.2.1 Используем Generation2 VM.

5.2.2 Используем fixed диски в VM.

Если жизнь на Марсе?

Вроде жизнь удалась, тесты показывают, что расчеты и ставки были верны и теперь наступит та самая искомая нирвана… Так я думал и надеялся до тех пор, пока мы в тестовом режиме не поставили кластер для разработчиков.Врать не буду, установка действительно происходит просто и незатейливо. Система сама проверяет все, что ей нужно для счастья, и если чего нет, то отправляет вас за этим в ближайший гастроном показывает подробный отчет о том, что не так и даже дает советы по устранению проблемы. В этом плане мне продукт от Microsoft понравился гораздо больше.

Тут же вспомнилась история о пятидневной переписке с техподдержкой VMware о проблеме при переходе на 5.5. Оказалось, веселая штука. Если ты заводишь на SQL-сервере отдельную учетную запись для подключения vSphere, то пароль у нее должен быть не длиннее 14 символов (или 10, сейчас уже не помню), ибо дальше система банально обрезает и выкидывает как ненужную часть кусок пароля. Действительно, вполне себе обоснованное поведение.

Но все веселье началось позже. Один сервер вылетел и отказался видеть сетевую карту (в итоге ОС тут оказалась не при чем). Потом сервера начали терять кворум. Потом сервера хаотически стали вылетать из кластера. VMM толком не работал и зачастую просто не мог подсоединится к ферме. Потом сервера стали вставать на паузу в кластере. Потом при миграции машины стали видеться на двух хостах. В целом ситуация была близка к катастрофе, как мы думали.

Но, собравшись с духом, мы, все-таки, решили повоевать. И знаете, что? Все получилось. И оказалось, что проблемы с сетевой картой были аппаратные, проблема с кластером решились после правильной настройки сети. А после того, как мы переставили хостовые ОС и VMM на английские версии вообще все стало хорошо. И тут мне стало грустно… 2017 год, а все еще нужно ставить английскую Windows чтобы было меньше проблем. Это epic fail на мой взгляд. Зато бонусом получили гораздо более простой поиск по тексту ошибок.

В итоге кластер завелся, VMM работает корректно, а мы начали раздавать виртуалки пользователям.

Кстати, отдельного котла в аду заслуживает тот, кто придумал интерфейс и логику VMM… Сказать, что он непонятный — это ничего не сказать. При первом открытии у меня появилось полное ощущение что я смотрю на приборную доску корабля пришельцев. Вроде формы знакомые, но понимания что тут что и зачем нет никакого. Хотя возможно через много лет я привыкну. Или просто заучу действия как обезьянка.

Каково это, когда все-таки завел трактор?

В целом эмоции и ощущения у меня от перехода положительные. Шаблоны и их возможности для ОС от Microsoft не идут ни в какое сравнение с аналогами у VMware. Они прям очень удобные, с огромным количеством всяких свистелок и рюшечек, которые в целом достаточно толковые. Пока гоняем кластер для разработчиков, привыкаем к новой жизни.Еще очень сильно, но очень приятно удивил вопрос миграцией машин из VMWare. Изначально я читал форумы, искал софт, думал как это будет. Оказалось, за меня уже все придумали. Мы в два счета подключили в VMM vCenter и прямо из VMM сказали «дорогой товарищ, дайте, пожалуйста, вот тех конфеток, уж больно они вкусные смигрируй мне пожалуйста вот эту виртуалку на новый гипервизор.» И самое что забавное — смигрировал. С первого раза. Без бубна и ошибок. И в итоге миграция, на тест которой я планировал выделить неделю уложилась в 40 минут, из которых 20 была сама миграция.

Чего не хватает:

- Маленького дистрибутива, заточенного именно под виртуализацию (аналога esxi).

- Нормальной консоли управления (консоль неудобная, особенно после управлялки от VMware, но есть надежда на проект Гонолулу. Во всяком случае, глядя на техническое превью, возникает понимание что продукт должен дать то самое удобство управления).

- Технической поддержки продукта виртуализации. Да, я знаю, что есть Premium Support, но это совсем не то, чего хочется.

Подводя итоги (если вам лень читать статью):

- Сейчас производительность двух платформ примерно одинакова.

- Производительность 1С такая же.

- В Hyper-V виртуальные диски можно как увеличивать, так и уменьшать. Причем онлайн.

- Очень, ну прямо очень, простая миграция с VMWare.

- Беда с поддержкой в привычном ее понимании.

- VMM крайне неудобная штука, особенно после vCenter. Но с другой стороны VMM это просто графическая оболочка для скриптов PowerShell, так что можно рулить всем этим через привычный Powershell CLI.

- Переход требует переучиваться и разбираться с тонкостями именно Hyper-V. Многие вещи и идеологические подходы разнятся.

- Шикарные шаблоны виртуальных машин с Windows. Удивительно удобно.

- Экономия денег.

- Более интересная на мой взгляд реализация Software-defined storage, но это «на любителя».

- Уважение за то, что весь Azure построен на собственных технологиях, которые потом приходят on-premise.

- Простая и очень плотная интеграция с облаком.

- Неплохая виртуализация сети, с многими любопытными моментами.

- На мой взгляд VDI – это не к Microsoft и Hyper-V. Но с другой стороны стрим проложений (RemoteApp) сделан весьма добротно, и для большинства компаний мало чем будет хуже, чем тот же Citrix.

- Слабая поддержка сторонними вендорами готовых образов виртуалок для Hyper-V (предположу, что явление временное).

- Весьма странная новая лицензионная политика (по ядрам).

Об авторе

Антон Литвинов – последние 6 лет работает в компании 585/Золотой. Прошел путь от сетевого инженера до руководителя отдела инфраструктурных решений и в итоге совмещает в себе мистера Джекила и доктора Хайда — фуллстак инженера и руководителя. В ИТ уже примерно 20 лет.habr.com

Установка и настройка Windows Hyper-V Server

Многие что-то слышали о виртуальных машинах, что-то о VirtualBox, что-то об установке второй ОС на компьютер. Однако вот о Hyper-V представление имеют немногие. А зря, поскольку программа является неплохим гипервизором, который также позволяет ставить ещё одну или две дополнительные операционные системы и не только. Главное, знать, как провести установку и настройку Windows Hyper-V Server.

Что, зачем и как

Сначала следует разобраться с терминологией. А не то у начинающего юзера волосы встанут дыбом от такого обилия непонятных слов.

- Гипервизоры создают виртуальные машины.

- Гипервизор — специальный софт, позволяющий делить наш ПК на один «настоящий» и несколько либо также один виртуальный.

- Виртуальная машина — это и есть этот самый несуществующий компьютер. Создаёт его гипервизор. Но на такой компьютер также можно поставить ОС (в зависимости от системы, которая её создаёт: любую или ряд определённых, например, только из семейства Windows) а потом управлять ею из окна приложения или как-то ещё.

- Аппаратная виртуализация — создание виртуальной реальности внутри ПК. Систему аппаратной виртуализации часто представляет собой упомянутый десять раз вверху гипервизор. Его ещё можно назвать «менеджер виртуальных машин».

- Гостевые ОС — операционные системы, располагающиеся на виртуальных машинах.

Что нам всё это даёт?

- Возможность ставить на компьютере сразу две операционки. Что довольно классно, если ставить не Виндовс, а что-то поинтереснее: ту же Ubuntu.

Виртуальная машина позволяет установить две операционные системы на одном компьютере

- Возможность тестирования различных программ и ОС. Этот пункт пригодится скорее программистам или айтишникам, нежели простым пользователям. Но если вы — начинающий представитель одной из этих профессий, то уметь обращаться с системами аппаратной виртуализации вам будет очень даже кстати.

- Использование программ, для нашей «оси» не предназначенных. Тех же игр, например. Поставить ОС от PlayStation 3 у вас конечно не получится (хотя ничего невозможного нет!), но вот Windows XP — запросто, а на ней легко запускать множество старых игрушек.

- Понимание сути различных процессов на компьютере. Единственный способ перестать видеть фигу и в мониторе — постоянно практиковаться и выполнять простые (для специалистов) задачи. Но книги и статьи наподобие этой, конечно, тоже никто не отменял.

Как всё это относится к Hyper-V? Программа является этим самым гипервизором. Наряду с ней ещё есть VirtualBox и ряд других приложений, выполняющих похожие функции. Чем пользоваться — решать вам, а здесь конкретно о Hyper-V.

- Работает этот софт только на 64-разрядных системах. При этом создавать внутри можно и 32-разрядные.

- «Родителем» Hyper-V являются одноимённые серверные программы от Microsoft. «Серверные» означает, что выпускались они для специальных серверных операционных систем.

- Идёт в комплекте с системами Виндовс 8, 8.1 и 10. На Windows 7, к сожалению, Hyper-V ещё не было.

Работа с программой

Для установки программы необходим современный компьютер

Hyper-V имеет системные требования, на которые следует обратить внимание, прежде чем его устанавливать.

- Оперативная память не менее 4 Гб.

- Процессор, оснащённый аппаратной визуализацией. Технологии называются Intel-VT или AMD-V (могут обозначаться как VMX или SVM).

- Технологии Intel EPT или AMD RVI.

Определить, есть две последних составляющих в вашем ПК или нет, поможет утилита Coreinfo. Скачать её можно с официального сайта «Майкрософт». Coreinfo представляет собой окошко с текстом, в котором будут либо прочерки напротив интересующих вас параметров — их нет — либо сведения об их наличии.

Установка Hyper-V

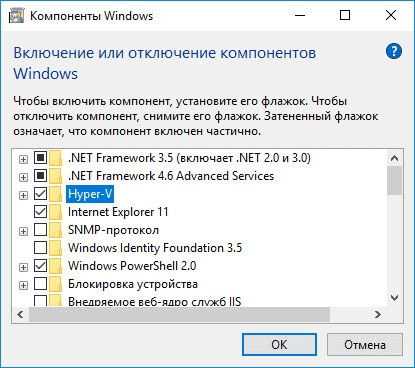

Если с системными требованиями всё в порядке, переходим к установке Hyper-V. На Windows 10/8/8.1 программа уже есть, поэтому всё, что нужно сделать — запустить её.

- Нажимаем Win+R для запуска командной строки.

- Вводим: Optional Features

- Находим в компонентах Windows Hyper-V, ставим маркер.

Cтавим маркер возле Hyper-V

- Жмём ОК.

- Перезагружаем ПК.

Итак, установленный гипервизор есть, осталось заставить его работать как надо и создать виртуальную машину.

Создание виртуальной машины

Настройка виртуальных машин в Hyper-V, как можно догадаться, гораздо сложнее, нежели установка. Однако и с этим можно справиться даже новичку.

- Запускаем программу.

- Нажимаем кнопку «Создать» в правом верхнем углу, затем — «Виртуальная машина».

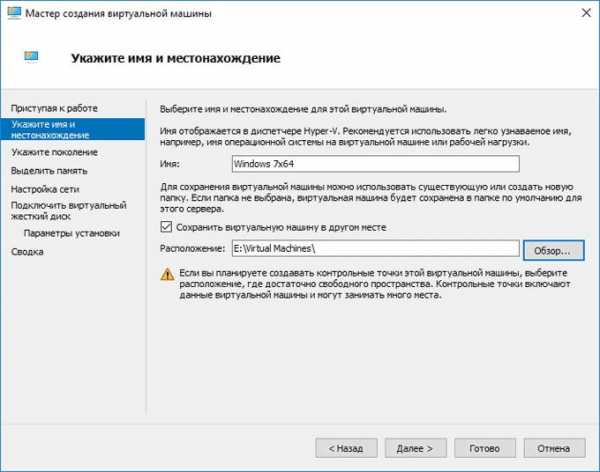

- Появляется мастер создания, читаем информацию, жмём «Далее».

- Придумываем имя. Расположение можно не менять.

Указываем имя и расположение

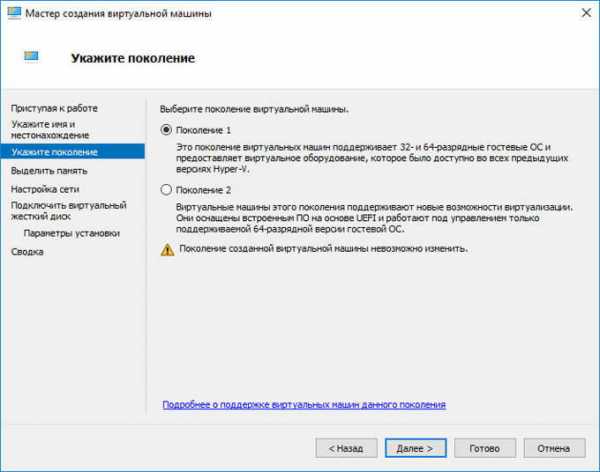

- Далее перед нами на выбор два поколения. Те или иные гостевые ОС могут устанавливаться на одном и не устанавливаться на другом. Поэтому при самостоятельной установке «оси» проверьте разрядность системы и имеют ли они загрузочный носитель UEFI. Мы выбираем второй вариант, так как устанавливаем новую сборку Windows.

Выбор поколения Hyper-V

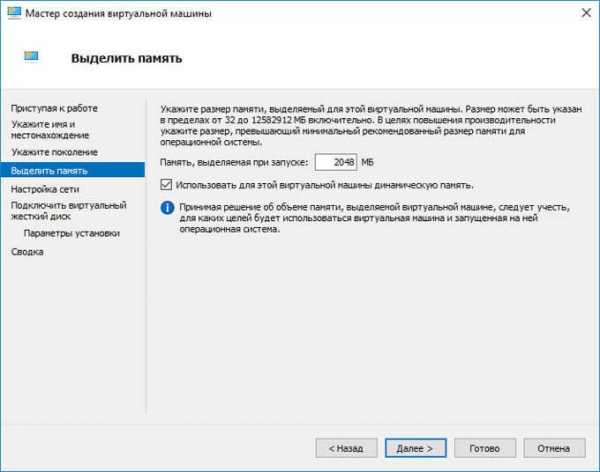

- В следующем окне необходимо выбрать выделяемую оперативную память. Лучше так и оставить 1024 Мб. Однако если на компьютере оперативка выше 4 Гб, то можно позволить больше. Если же вы собираетесь устанавливать XP или другую лёгкую операционку, можно выделить и меньше.

Указываем объем памяти

- Далее находим виртуальный коммутатор в списке подключений к сети, если мы его создали.

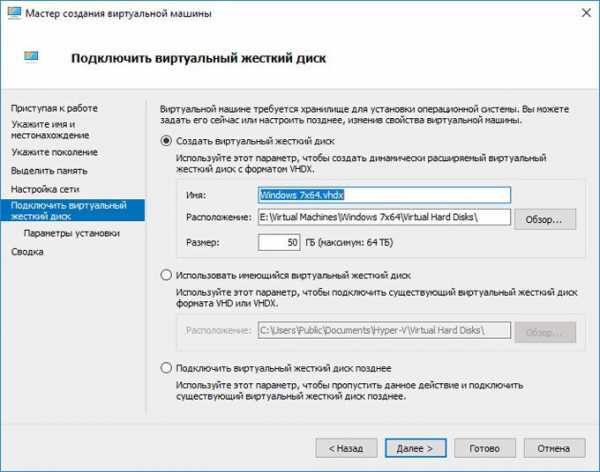

- Создаём виртуальный жёсткий диск, указываем его расположение и размер.

Подключаем виртуальный жесткий диск

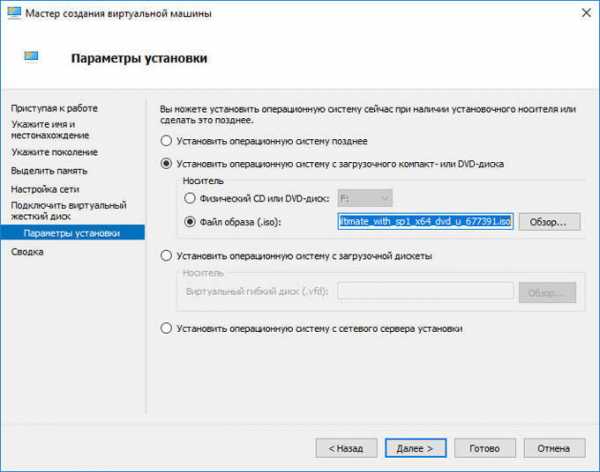

- В завершение указываем путь к файлу образа системы.

Указываем путь к файлу образа системы

- Проверяем все данные и жмём «Готово».

На этом настройка ещё не заканчивается. Теперь нужно запустить машину и научиться эффективно ей пользоваться.

Запуск, подключение к сети и некоторые фишки

Сначала рассмотрим сам запуск новой ОС.

- В списке в окне Hyper-V отображаются все виртуальные машины. У нас она, скорее всего, одна.

- Выбираем её, щёлкаем правой кнопкой мыши и жмём «Подключить».

- Она разворачивается на всё окно. Чтобы запустить, нужно нажать на круглую кнопочку вверху. Оттуда же выполняются и остальные действия с виртуальной системой.

- Жмём любую кнопку.

- Теперь работаем уже с той ОС, ISO-образ которой мы загружали.

Всё, машина запущена. При закрытии окна мы просто сворачиваем её и она продолжает работать в фоновом режиме.

Кроме непосредственно подключения машины, важно уметь настраивать и подключение к сети. Делается это следующим образом.

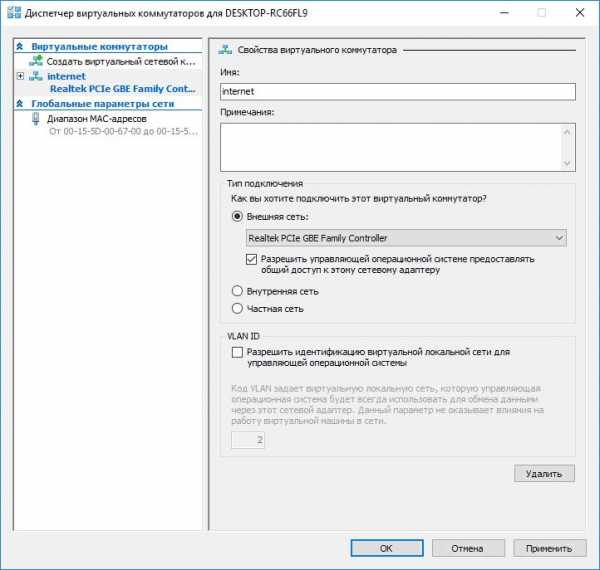

- Открываем диспетчер создания виртуальных коммутаторов. Находится он в меню «Действия».

- Выбрать можно три сети: внешняя, внутренняя и частная. Коротко: внешняя — виртуальный компьютер–интернет, внутренняя — виртуальный–физический, частная — виртуальный–виртуальный. Настроим соединение с интернетом.

- Придумываем имя. Ставим галочку «Внешняя сеть» и находим в списке «Family Controller» либо другой тип подключения.

Указываем имя внешней сети

- Жмём применить.

Подключение к сети можно создать как до, так и после создания «дочерней» ОС, от этого ничего не изменится. Машина всё равно подключится к новоявленному коммутатору.

После установки и настройки Hyper-V одной из проблем, которая остаётся при работе с системами, является передача файлов с физического компьютера на созданный нами. Для её решения лучше всего подойдёт подключение к удалённому рабочему столу.

- Открываем командную строку на виртуальном ПК (Win+R). Вводим: EXE shell32.dll,Control_RunDLL sysdm.cpl,,5

- Разрешаем подключение, это самый нижний маркер во вкладке «Удалённый доступ».

- Теперь вводим в командной строке: ipconfigКоманда нужна для того, чтобы узнать IP-адрес. Копируем или записываем его.

- Теперь переходим на физический компьютер.

- В командной строке вбиваем: mstsc

- Вводим IP, точное имя пользователя, разрешаем сохранить учётные данные. После нажимаем «Сохранить», а затем «Подключить».

Теперь мы можем переключаться между рабочими столами виртуального и реального компьютеров. Что это даёт? Перенос файлов стандартным методом: ctrl + C, ctrl + V. Без подключения удалённого рабочего стола такой способ работает только с текстом.

Где брать ОС?

Вопрос, который у многих наверняка возник, когда они читали о создании виртуальной машины. Операционные системы или, вернее, дистрибутивы можно скачать с различных специализированных ресурсов. Важно проследить, чтобы это был ISO-образ. Пробные версии Windows можно будет использовать три месяца. Если говорить о дистрибутивах на Linux, то большинство из них бесплатны, важнее найти подходящую сборку и заключить её в ISO.

Теперь у вас есть хотя бы небольшое представление о Hyper-V. Конечно же, все функции, сложности и возможности программы не описать в одной статье. Но после прочтения вы сможете легко выполнять ряд базовых действий. А затем и самостоятельно установить систему, не принадлежащую к семейству Виндовс.

nastroyvse.ru

рекомендации ведущих собаководов / Хабр

Прежде, чем строить инфраструктуру на базе виртуализации, и, тем более – вводить ее в промышленную эксплуатацию, необходимо позаботиться о том, чтобы ресурсы системы использовались наиболее эффективно, и производительность была максимальной. В этом цикле статей я дам рекомендации о том, как оптимизировать систему по производительности – как со стороны хоста, так и со стороны виртуальных машин.

Начнем с хоста

Поскольку сервера, хостящие виртуальные машины, достаточно часто работают на пиковых нагрузках – производительность таких серверов имеет решающее значение для производительности всей системы. Потенциальными «узкими местами» могут являться:- Процессор

- Память

- Дисковая подсистема

- Сетевая подсистема

Процессор – сердце компьютера

«Сердцем» любого компьютера является процессор. И правильность выбора процессора в контексте виртуализации – становится еще важнее. Процессор – самая дорогая часть любого компьютера, и выбор слишком мощного процессора может привести к лишним затратам не только на покупку самого процессора, но и в дальнейшем – на электроэнергию и охлаждение. Если же процессор будет недостаточно мощным – система не сможет обеспечить необходимую производительность, что может вылиться в покупку нового процессора – и, следовательно, опять затраты. Нам необходимо получить ответы на следующие ключевые вопросы:- Сколько ставить процессоров?

- Сколько нужно ядер?

- Их скоростные характеристики?

- Требуется больше лицензий на ПО – как на сами ОС, так и на ПО управления (SCVMM, SCCM, SCOM, etc.)

- Возрастают затраты на администрирование – три сервера вместо одного

- Три сервера потребляют больше энергии, а значит – выделяют больше тепла, и занимают больше места в стойке, чем один сервер, пусть и более мощный.

- Hyper-V Hypervisor Virtual Processor, % Total Run Time — этот счетчик отображает загрузку виртуальных процессоров. Можно задать отображение суммарной загрузки всех процессоров для запущенных виртуальных машин, а можно выбрать конкретный виртуальный процессор конкретной виртуальной машины.

- Hyper-V Hypervisor Root Virtual Processor, % Total Run Time – а этот счетчик показывает загрузку выбранных логических процессоров задачами, не связанными с Hyper-V.

Памяти много не бывает

Мощный процессор – это хорошо, но при недостатке памяти система начинает использовать файлы подкачки, и производительность начинает падать едва ли не экспоненциально. Как говорят в интернете – «512 мегабайт – это не память, это маразм». К сожалению (а скорее всего – к счастью) в Hyper-V невозможно выделить виртуальным машинам больше памяти, чем физически присутствует в системе. Это то, что называют «memory overcommit», и чем с такой радостью играет маркетинг других вендоров решений виртуализации. Хорошо это или плохо – это тема отдельной статьи, и об эту тему было сломано уже не мало виртуальных копий. В связи с этим возникает вопрос: а сколько памяти нам в итоге необходимо? Ответ зависит от разных факторов:- Сколько виртуальных машин будет запущено, и сколько памяти им понадобится? Объем памяти, необходимый каждой виртуальной машине зависит от задач, которые она будет выполнять. Подход тот же самый, что и для обычных серверов, но память виртуальным машинам можно выделять более гибко – не 1024 Мб, а, к примеру, 900 Мб.

- Хостовой ОС тоже нужна память. Рекомендуется оставлять как минимум 512 Мб свободной памяти на нужды гипервизора и самой хостовой ОС. Если объем свободной памяти опустится ниже 32 Мб – система не даст запустить больше ни одной виртуальной машины, пока память не освободится. Кроме этого, в хостовой ОС могут выполняться какие-то другие задачи, помимо виртуализации. Хотя это и крайне не рекомендуется, но факт все же имеет место быть, и это необходимо учитывать.

- Другие виртуальные машины (для сценариев Live Migration). Если инфраструктура планируется на базе отказоустойчивого кластера, то необходимо на каждом из хостов предусмотреть дополнительные объемы памяти. Дело в том, что виртуальные машины могут перемещаться с одного хоста на другой в случае ручного перемещения (Live Migration), или же в случае отказа одного из хостов. Если на хосте будет недостаточно памяти для запуска перемещаемых виртуальных машин – то они попросту не смогут на нем запуститься. Поэтому на этапе проектирования надо предусмотреть «неприкосновенный запас» в размере 50-100% от необходимого объема памяти. Возможно, ситуация немного улучшится с выходом Windows Server 2008 R2 SP1, в который входят технологии динамического распределения памяти, но точно я смогу сказать лишь тогда, когда сам это протестирую.

Жесткие диски: сколько их надо?

Как правило, достаточно трудно предсказать, сколько дискового пространства потребуется виртуальным машинам для работы. И потому ситуации, когда дискового пространства не хватает, или же наоборот – когда его слишком много и диски простаивают – встречаются довольно часто. Помимо объема, есть еще одна очень важная характеристика – быстродействие дисковой подсистемы. 2 Тб дискового пространства – это конечно же хорошо, но если это два SATA-диска, не объединенных в RAID-массив – то пропускной способности может попросту не хватить, и это сильно скажется на быстродействии системы. Планирование подсистемы хранения данных включает в себя следующие аспекты: Контроллеры. Контроллеры жестких дисков могут иметь разную разрядность шины, разный объем кэш-памяти, и вообще их быстродействие может сильно различаться. Некоторые контроллеры являются полностью «аппаратными», то есть обрабатывают все запросы самостоятельно, а некоторые – «полусофтовые», то есть часть обработки запросов выполняет процессор самого компьютера. От типа контроллера в первую очередь зависит быстродействие дисковой подсистемы, и выбирать контроллер нужно грамотно. Тип дисков. Жесткие диски, помимо объема, имеют множество других характеристик, о которых нельзя забывать. Это и тип интерфейса (IDE, SATA, SCSI, SAS), и скорость вращения шпинделя (7200, 10000, 15000 об/мин), и объем кэш-памяти самого жесткого диска. Разница, к примеру, между диском на 7200 и 10000, а тем более – 15000 об/мин, или между 8 и 32 Мб кэш-памяти – для таких высоконагруженных систем, как хосты виртуализации – достаточно высока. Количество дисков и тип RAID-массива. Как уже было сказано, иногда, для достижения более высокой производительности, и надежности, наилучшим решением станет не установка одного диска большого объема, а объединение нескольких дисков меньшего объема в RAID-массив. Есть несколько типов RAID-массивов:- RAID 0 – «массив с чередованием». Информация пишется блоками («страйпами») одновременно на несколько дисков. Благодаря этому чтение и запись больших объемов информации происходит значительно быстрее, чем с одного диска, и тем быстрее, чем больше дисков в массиве. Но есть один большой недостаток: низкая надежность. Выход из строя любого из дисков приведет к полной потере информации. Поэтому на практике RAID 0 используется достаточно редко. Один из примеров – промежуточное хранилище резервных копий в модели «Disk-to-disk-to-tape», когда надежность не так важна, как быстродействие.

- RAID 1 – «зеркалирование». При такой модели информация записывается одновременно на несколько дисков, причем содержимое всех дисков абсолютно идентично. Скорость записи и чтения не выше, чем для одиночного диска, но намного выше надежность: выход из строя одного диска не приведет к потере информации. Недостаток лишь один: высокая стоимость – там, где хватает и одного диска – приходится ставить два и более. Смысл имеет в тех случаях, когда надежность имеет решающее значение.

- RAID 4 и RAID 5 – «чередование с контролем четности». Предстваляет собой некую «золотую середину» между RAID 0 и RAID 1. Смысл состоит в том, что информация хранится на дисках как и в случае RAID 0 — блоками с чередованием, но помимо этого вычисляются контрольные суммы хранимых данных. В случае отказа одного из дисков – недостающие данные автоматически вычисляются по имеющимся данным и контрольным суммам. Разумеется, это приводит к снижению производительности, но в то же время данные не теряются, и при замене сбойного диска вся информация восстанавливается (этот процесс называется перестройкой массива). Потеря данных произойдет только при отказе двух и более дисков. Такие массивы отличаются тем, что скорость записи у них значительно ниже, чем скорость чтения. Происходит так из-за того, что при записи блока данных происходит вычисление контрольной суммы и запись ее на диск. RAID 4 и RAID 5 отличаются тем, что в RAID 4 контрольные суммы записываются на отдельный диск, а в RAID 5 – хранятся на всех дисках массива вместе с данными. В любом случае, для организации такого массива нужно N дисков для хранения данных плюс один диск. В отличие от RAID 1 и RAID 10, где количество дисков просто удваивается.

- RAID 6 – он же RAID DP, double-parity, двойная четность. То же самое, что и RAID 5, но контрольные суммы вычисляются два раза, с использованием различных алгоритмов. Хотя дисков здесь требуется уже не N+1, как с RAID 5, а N+2, зато такой массив может пережить даже одновременный отказ двух дисков. Встречается относительно редко, как правило – в системах хранения данных Enterprise-уровня, к примеру – NetApp.

- RAID 10 – «гибрид» RAID 0 и RAID 1. Представляет собой RAID 0 из нескольких RAID 1 (и тогда называется RAID 0+1) или наоборот – RAID 1 из нескольких RAID 0 (RAID 1+0). Отличается наивысшей производительностью, как по записи, так и по чтению, но в то же время отличается и высокой стоимостью – так как дисков требуется в 2 раза больше, чем необходимо для хранения данных.

- Physical Disk, % Disk Read Time

- Physical Disk, % Disk Write Time

- Physical Disk, % Idle Time

- Physical Disk, Avg. Disk Read Queue Length

- Physical Disk, Avg. Disk Write Queue Length

Сетевая подсистема

Сетевая подсистема бывает «узким местом» намного реже, чем процессор, память и жесткий диск, но тем не менее – о ней не стоит забывать. Как и со всеми остальными компонентами – имеется несколько вопросов, на которые неплохо было бы получить ответы еще на этапе планирования:- Сколько виртуальных машин будет запущено одновременно, и какова будет нагрузка на сеть?

- Какова пропускная способность сети?

- Используются ли системы хранения данных с интерфейсом iSCSI?

- Есть ли у сервера аппаратные средства удаленного управления, не зависимые от установленной ОС (к примеру – HP iLO или Dell DRAC)?

Рекомендации для хостовой ОС

Теперь перейдем к рекомендациям по ОС хоста. Как известно, ОС Windows Server 2008 R2 может быть установлена в двух разных режимах: Full и Server Core. С точки зрения работы гипервизора эти режимы ничем не отличаются. Хотя режим Server Core на первый взгляд кажется сложнее (особенно для малоопытных администраторов), рекомендуется использовать именно этот режим. Установка ОС в режиме Server Core имеет следующие преимущества по сравнению с полной установкой:- Меньший объем обновлений

- Меньшая поверхность атаки для потенциальных злоумышленников

- Меньшая нагрузка на процессор и память в родительской партиции

Рекомендации для виртуальных машин

Шаги, которые необходимы предпринять для повышения производительности самих виртуальных машин – зависят от приложений, которые будут на них выполняться. У Microsoft имеются рекомендации (best practices) для каждого из приложений – Exchange, SQL Server, IIS, и других. Аналогичные рекомендации существуют для ПО других вендоров. Здесь я дам лишь общие рекомендации, не зависящие от конкретного ПО. Здесь будет рассказано, почему нужно устанавливать Integration Services в гостевой ОС, как упростить развертывание новых виртуальных машин с помощью библиотеки VHD, и как поддерживать эти VHD в актуальном состоянии с выпуском новых патчей.Сервисы интеграции

Сервисы интеграции – это набор драйверов, работающих внутри гостевой ОС. Они должны быть установлены сразу после установки ОС. На данный момент список поддерживаемых ОС следующий:- Windows 2000 Server SP4

- Windows Server 2003 SP2

- Windows Server 2008

- Windows XP SP2, SP3

- Windows Vista SP1

- SUSE Linux Enterprise Server 10 SP3 / 11

- Red Hat Enterprise Linux 5.2 – 5.5

- IDE-контроллер – заменяет собой эмулируемый IDE-контроллер, что повышает скорость доступа к дискам

- SCSI-контроллер – является полностью синтетическим устройством и требует для работы обязательной установки интеграционных сервисов. К каждому SCSI-контроллеру можно подключить до 64 дисков, самих контроллеров может быть до 4 на каждую виртуальную машину.

- Сетевой адаптер – имеет более высокую производительность, чем эмулируемый (Legacy Network Adapter), и поддерживает особые функции, такие, как VMQ.

- Видео и мышь – повышают удобство управления виртуальной машиной через ее консоль.

- Operating System Shutdown – возможность корректного завершения работы гостевой ОС без логина в нее. Аналогично нажатию кнопки Power на корпусе ATX.

- Time Synchronization – ясно из названия – синхронизация системного времени между хостовой и гостевой ОС.

- Data Exchange – обмен ключами реестра между гостевой и хостовой ОС. Таким образом, к примеру, гостевая ОС может определить имя хоста, на котором она запущена. Эта возможность доступна только для гостевых ОС семейства MS Windows.

- Heartbeat – специальный сервис, периодически отправляющий специальные сигналы, означающие, что с виртуальной машиной все в порядке. Если гостевая ОС по какой-то причине, например, зависнет – она перестанет отправлять Heartbeat, и это может служить сигналом, к примеру, для автоматической перезагрузки.

- Online Backup – представляет из себя VSS Writer, позволяющий в любой момент получить консистентную резервную копию данных виртуальной машины. При запуске резервного копирования через VSS приложения, запущенные на виртуальной машине автоматически сбрасывают данные на диск, и потому бэкап получается консистентным.

Sysprep: создаем мастер-образ

Если у вас имеется достаточно большая инфраструктура, и вам приходится часто создавать новые виртуальные машины и устанавливать на них ОС –набор готовых «мастер-образов» виртуальных жестких дисков поможет сильно сэкономить время. Такой «мастер-образ», хранящийся в виде VHD-файла, можно скопировать, а затем создать новую виртуальную машину с использованием VHD в качестве жесткого диска. При этом на нем уже будет установлена ОС и некоторый необходимый набор ПО (в частности – сервисы интеграции). Для создания такого мастер-образа необходимо:- Создать новую виртуальную машину

- Произвести установку ОС, сервисов интеграции, всех доступных обновлений системы и дополнительного ПО, если таковое необходимо

- Подготовить установленную ОС с помощью утилиты Sysprep, которая удалит информацию о пользователе, ключе продукта и уникальный идентификатор (SID).

Оффлайн-установка обновлений

Мы создали мастер-образ, и он будет храниться у нас в течение длительного времени. И все бы ничего, но есть одна небольшая проблема: периодически выходят обновления системы, и при развертывании виртуальной машины с мастер-образа придется установить все обновления, вышедшие с момента создания мастер-образа. Если образ был создан, скажем, год или два тому назад – объем обновлений может быть достаточно большим. Кроме того, сразу после подключения к сети ОС без последних обновлений подвержена всевозможным угрозам безопасности, в том числе – и вирусам. Есть прекрасный инструмент, позволяющий устанавливать обновления прямо на мастер-образы виртуальных машин – он называется «Offline Virtual Machine Servicing Tool». Для его использования необходимо развернуть System Center Virtual Machine Manager (SCVMM), а так же иметь развернутый сервер WSUS или SCCM, откуда, собственно говоря, обновления и будут подтягиваться. Принцип его действия следующий:- Виртуальная машина разворачивается на специальном, выбираемом с помощью SCVMM, хосте – так называемый maintenance host.

- Виртуальная машина запускается, и на ней производится установка всех необходимых обновлений.

- Виртуальная машина останавливается, и VHD-файл возвращается в библиотеку уже с установленными обновлениями.

Заключение

Я дал некоторые рекомендации по настройке хостов и самих виртуальных машин, позволяющей достичь оптимального уровня производительности. Буду надеяться, что для кого-то эта информация окажется полезной.habr.com

Виртуализация сети в Hyper-V. Настройка / Блог компании Microsoft / Хабр

В прошлый раз я описал концепцию и общую архитектуру Hyper-V Network Virtualization (NV) – технологии Windows Server 2012, обеспечивающей виртуализацию на уровне сетевого сегмента. Сегодня речь пойдет о настройке этой технологии с помощью PowerShell и System Center 2012 SP1 Virtual Machine Manager (VMM). На хосте с развернутой ролью Hyper-V доступно несколько командлетов PowerShell, с помощью которых выполняется настройка требуемой конфигурации NV. Основных командлета четыре: Как обычно для PowerShell, существуют аналогичные команды с префиксами Get-, Set-, Remove- для получения текущих параметров, изменения и удаления соответственно.Еще пара командлетов, Get-NetVirtualizationGlobal и Set-NetVirtualizationGlobal позволяют определить (и, соответственно, задать), используется ли внешний Gateway для маршрутизации трафика.

Самый простой способ познакомиться с перечисленными командлетами – изучить и попробовать применить в тестовой среде два скрипта-примера, разработанных моими коллегами. Каждый скрипт содержит детальные комментарии, описание моделируемой среды и указание на те переменные и константы, которые вам необходимо заменить на собственные значения. Найти и скачать скрипты можно здесь:

Проверял лично, работает. :) Но, думаю очевидно, что в масштабах ЦОД-а манипуляция подобными скриптами превращается в крайне сложную задачу. Поэтому далее гораздо более детально я рассмотрю настройку NV с помощью VMM. Технология NV является частью Hyper-V в Windows Server 2012. System Center поддерживает Windows Server 2012, начиная с версии System Center 2012 SP1. Здесь и далее речь идет о VMM именно из System Center 2012 SP1. Я предполагаю, что VMM уже развернут, хосты Hyper-V в него добавлены, поэтому буду обращать внимание только на те настройки, которые непосредственно связаны с NV.Настройка NV с помощью VMM состоит из следующих шагов:

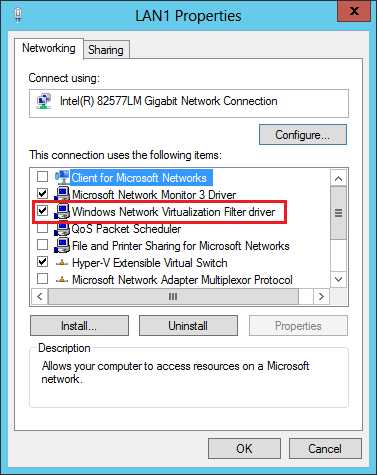

- Включение фильтра Windows Network Virtualization (WNV) на хостах с поднятой ролью Hyper-V.

- Включение NV для нужных логических сетей.

- Создание сетей виртуальных машин (VM Network) и пулов IP-адресов.

- Создание шаблонов виртуальных машин (VM Template) с привязкой к нужным сетям виртуальных машин.

- Развертывание ВМ с использованием подготовленных в п. 4 шаблонов.

Включение фильтра Windows Network Virtualization (WNV)

Вручную Напомню, что правила, определяющие работу NV, задаются в так называемой политике виртуализации. Определенные настройки, заданные в политике виртуализации, непосредственно к сетевым пакетам применяются драйвером-фильтром уровня NDIS (Network Driver Interface Specification), называемым Windows Network Virtualization (WNV). Этот фильтр необходимо включить на тех хостах Hyper-V, на которых планируется использовать NV. Вручную это делается в свойствах физического сетевого адаптера хоста. Подчеркиваю, именно физического адаптера, а не виртуального, который, как правило, создается при настройке внешнего свитча Hyper-V.

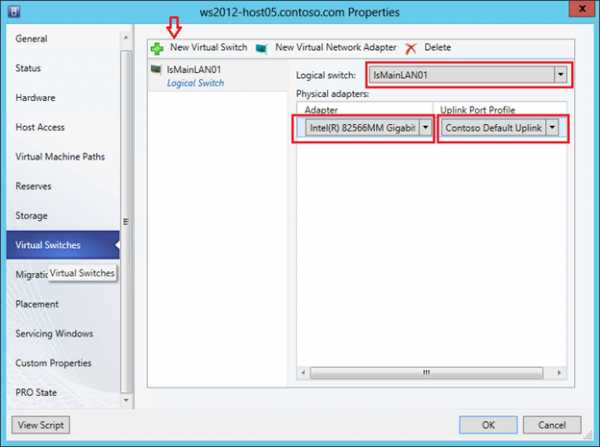

С помощью Logical Switch В качестве альтернативы ручной настройке можно использовать появившийся в VMM 2012 SP1 механизм логических свитчей (Logical Switch). Более подробное описание настроек сети в VMM можно найти вот в этом посте Георгия Гаджиева. Здесь же кратко упомяну, что логический свитч необходим для того, чтобы применить заданный набор настроек к сетевым адаптерам и свитчам Hyper-V Extensible Switch на множестве хостов. Найти описанные ниже настройки можно в разделе «Fabric», подразделе «Networking» консоли VMM. Фактически в логическом свитче можно задать три группы настроек: настройки для физических сетевых адаптеров хостов, настройки для виртуальных сетевых адаптеров ВМ (а точнее, для портов Hyper-V Extensible Switch, к которым ВМ подключаются) и настройки для расширений (extensions) Hyper-V Extensible Switch.

Первая группа настроек, а именно она нас больше всего интересует, задается путем создания специального профиля, который называется Uplink Port Profile. В профиле необходимо установить чекбокс, показанный на рисунке, благодаря которому и будет в дальнейшем включен фильтр WNV.

Вторая группа настроек задается путем создания профиля, который называется Virtual Adapter Port Profile. В этом профиле нет настроек, напрямую связанных с NV, но именно там можно задать различные параметры безопасности свитча (например, DHCP Guard), производительности (например, IP Sec offload), ограничения трафика (Quality of Service).

Ну а далее при создании логического свитча можно указать необходимые расширения для Hyper-V Extensible Switch, выбрать Virtual Adapter Port Profile и, самое главное, добавить Uplink Port Profile, в котором мы пометили чекбокс «Enable Windows Network Virtualization».

Тем самым, мы создали некоторый набор настроек в виде логического свитча. Остается применить созданный логический свитч к требуемым хостам Hyper-V, а как следствие, применятся к хостам и все настройки этого логического свитча. Для этого в консоли VMM в свойствах хоста переходим на закладку Virtual Switches, нажимаем «New Virtual Switch», затем «New Logical Switch» и выбираем нужный логический свитч. Проверяем, что для требуемого физического сетевого адаптера применяется тот самый Uplink Port Profile.

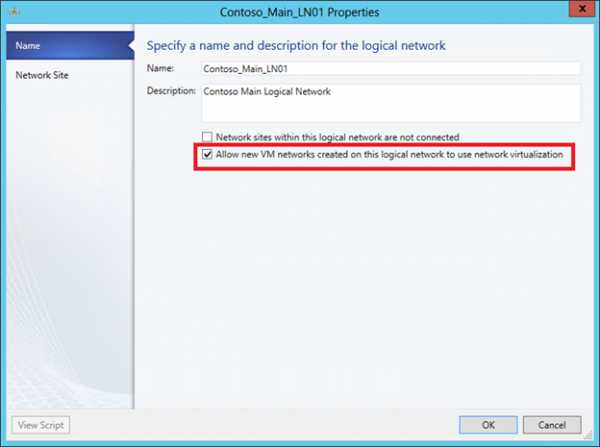

Включение NV для логических сетей

Следующий шаг – включение NV для требуемых логических сетей (Logical Networks). Логические сети в VMM позволяют администратору описать физическую сетевую топологию ЦОД-а. Это описание в дальнейшем помогает существенно упростить подключение ВМ к требуемым сетевым сегментам. Похожим образом администратор Active Directory (AD) с помощью сайтов и подсетей описывает физическую сеть предприятия для оптимизации трафика репликации AD. Применительно же к NV логические сети VMM не просто описывают реальную сетевую топологию, но и определяют пространство PA-адресов, которые будут использоваться для передачи пакетов между ВМ на разных хостах.Итак, представим себе, что в физической сети используется IP-адресация из диапазона 192.168.1.0/24. Нам же необходимо поверх этой сети виртуализовать сети двух компаний ОАО «Синие» и ОАО «Красные». Причем обе компании используют одинаковый диапазон IP-адресов, а именно: 10.0.0.0/24.

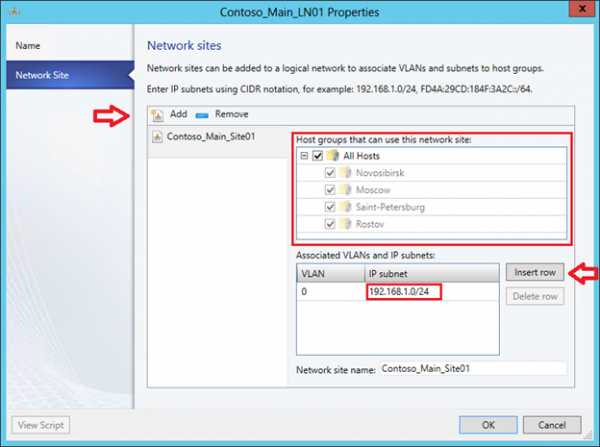

Создаем логическую сеть (кнопка меню «Create Logical Network») и на первом же экране разрешаем для этой сети NV:

На следующем экране создаем сайт и указываем, какие группы хостов могут этот сайт использовать (фактически в нем располагаются) и какие IP-подсети этому сайту принадлежат.

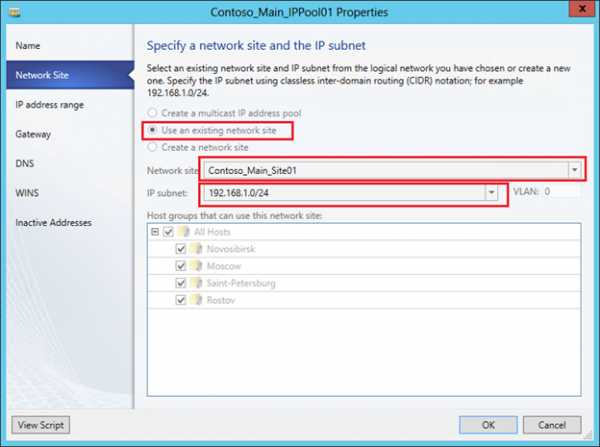

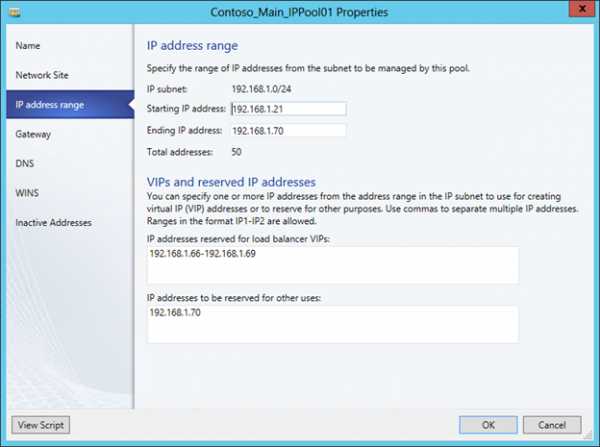

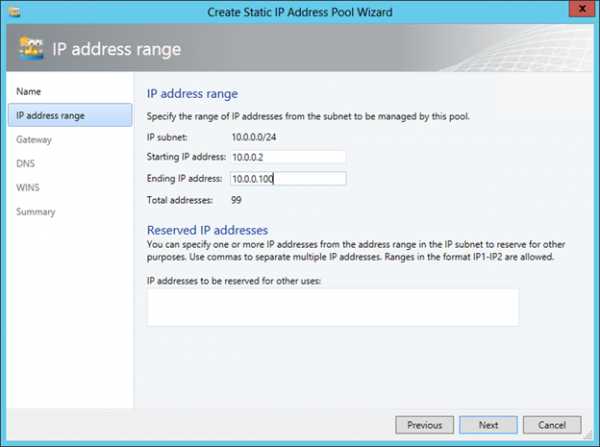

Теперь для этой логической сети необходимо создать пул IP-адресов. В контексте NV именно из этого пула VMM будет выделять PA-адрес и ассоциировать с ВМ и настроенными внутри них CA-адресами. В консоли VMM нажимаем «Create IP Pool», задаем имя пула и на следующем экране указываем для какого сайта и какой IP-подсети создаем пул.

Затем необходимо задать диапазон IP-адресов и, если требуется, какие-то адреса зарезервировать. Например так:

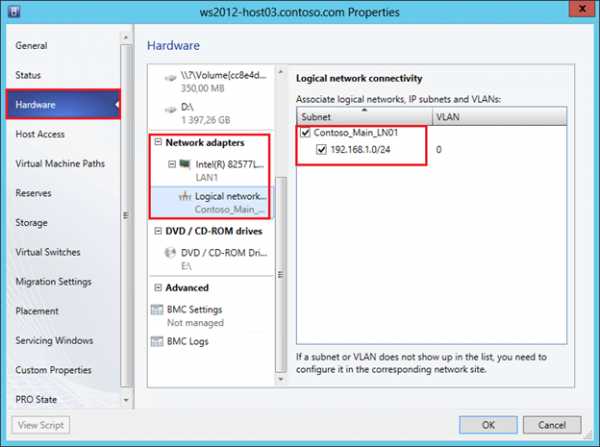

На последующих экранах можно указать адрес шлюза по умолчанию, а также адреса серверов DNS и WINS. Теперь, когда логическая сеть создана и настроена, остается указать, какие конкретно хосты Hyper-V будут с ней ассоциированы, или иными словами, на каких хостах могут быть запущены ВМ, требующие доступ к этой сети. В свойствах хостов на закладке «Hardware» надо выбрать сетевой адаптер хоста и пометить соответствующую логическую сеть.

Создание сетей виртуальных машин (VM Network) и пулов IP-адресов

На предыдущих шагах мы включили фильтр WNV и настроили логическую сеть с пулом IP-адресов, который будет использоваться для выделения PA-адресов. Таким образом, мы подготовили физическую инфраструктуру или, в терминологии VMM, подготовили Fabric. Теперь поверх этой инфраструктуры можно создавать и виртуализовывать произвольные сети клиентов нашего ЦОД-а. В рассматриваемом сценарии этими клиентами, как вы помните, являются компаний ОАО «Синие» и ОАО «Красные», использующие одинаковую подсеть 10.0.0.0/24.С выходом SP1 для System Center 2012 в VMM появился новый тип объектов – сеть виртуальных машин (VM Network), далее просто «сеть ВМ». В первую очередь, этот тип объектов предназначен для NV, хотя, как вы увидите в дальнейшем, даже если NV не используется, как минимум одну сеть ВМ создать необходимо. Ну а в нашем случае, очевидно, нужно создать две сети ВМ для «Синих» и «Красных» соответственно. Процесс этот очень похож на создание логической сети – мы создаем сеть ВМ, определяем в ней один или несколько сайтов с указанием подсетей, затем создаем для подсетей пулы IP-адресов. Но эти пулы уже будут использоваться для выделения CA-адресов виртуальным машинам.

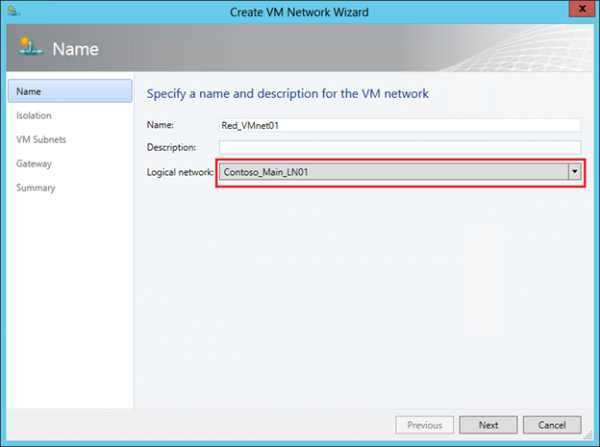

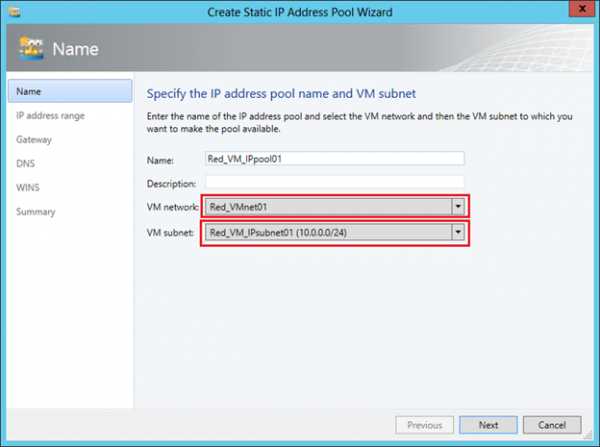

Итак, в консоли VMM переходим в раздел «VMs and Services» и нажимаем кнопку «Create VM Network». В первом окне задаем имя создаваемой сети и выбираем из списка логическую сеть, поверх которой будет работать данная сеть ВМ.

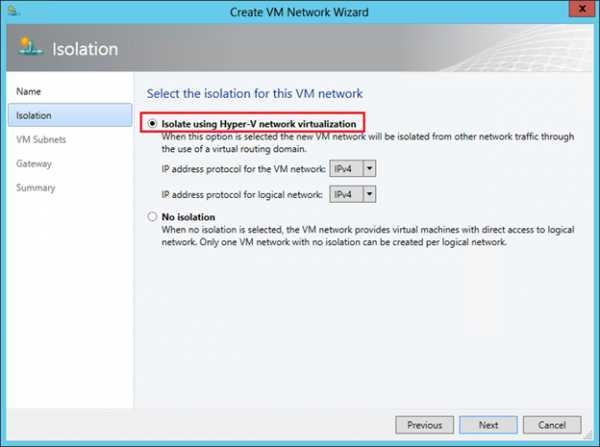

Следующий шаг весьма важный. Коль скоро мы настраиваем NV, выбираем верхний пункт. Он будет доступен для выбора только в том случае, если для логической сети, указанной на предыдущем шаге, была включена поддержка NV, что мы уже сделали.

Но здесь же хотел бы обратить ваше внимание на вторую опцию «No Isolation». Если выберем ее, то укажем тем самым VMM, что виртуальные машины этой сети должны напрямую (без изоляции) подключаться к логической сети. Никаких дополнительных настроек в этом случае уже не потребуется. Создаваемые затем ВМ буду получать IP-адреса из пулов, настроенных непосредственно в логической сети. То есть опцию «No Isolation» вы выбираете в том случае, когда технология NV вам не нужна. И поэтому закономерно, что для каждой логической сети можно создать только одну сеть ВМ без изоляции.

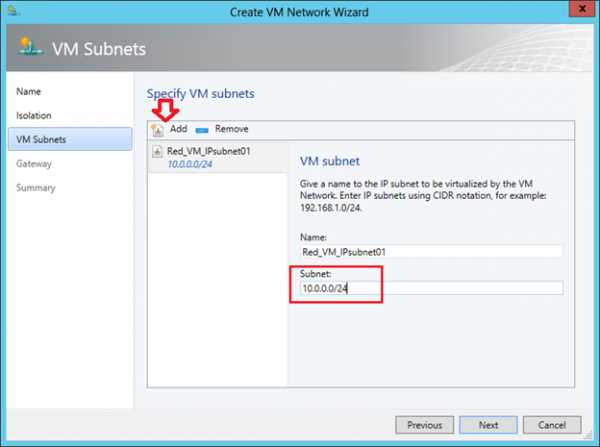

Мы же двигаемся дальше и в следующем окне создаем подсеть (одну или несколько), которая требуется клиенту.

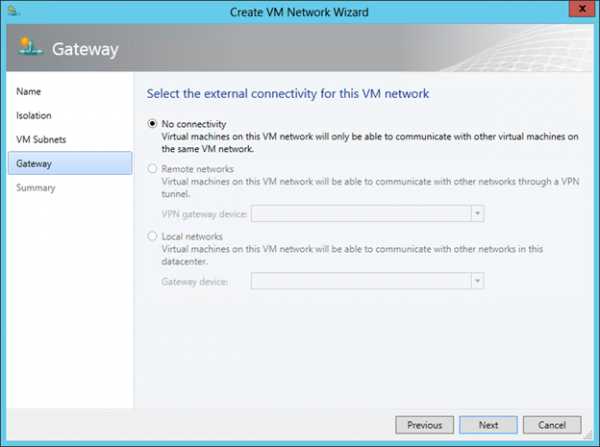

На завершающем экране мастера выбираем способ взаимодействия ВМ создаваемой сети с внешним миром. Поскольку мы не настраивали специально внешний шлюз (об этом речь пойдет в следующем посте), то выбор здесь один – «No Connectivity», означающий, что ВМ смогут взаимодействовать только в пределах этой сети ВМ.

Последняя задача данного этапа – настроить для созданной сети ВМ пулы адресов, то есть CA-адреса. В консоли VMM выбираем сеть ВМ и нажимаем «Create IP Pool». На первом экране проверяем, что указаны нужные сеть ВМ и подсеть:

На втором задаем диапазон IP-адресов для ВМ:

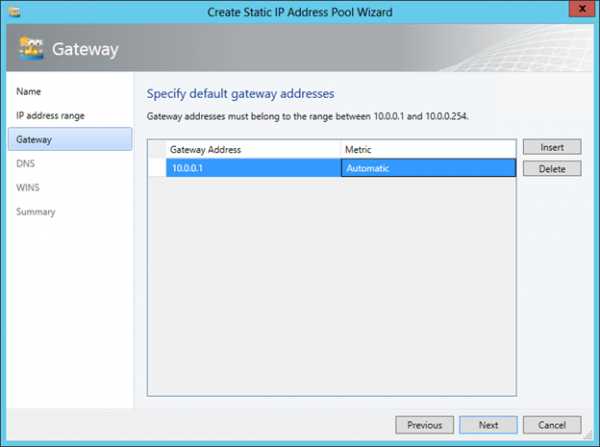

Указываем шлюз по умолчанию:

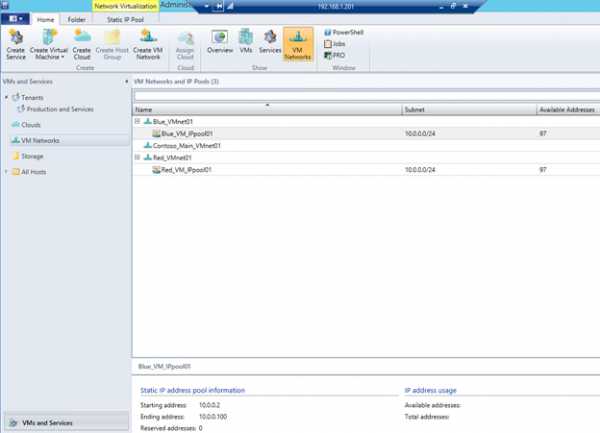

При необходимости задаем далее адреса серверов DNS и WINS. Сеть «Красных» настроена. Повторяем процедуру для ОАО «Синие» и в результате получаем вот такую картину:

Настройка собственно виртуализации сети на этом завершена. Если вспомнить концепцию и архитектуру NV, описанные мною в предыдущем посте, то становится понятно, что VM Network соответствует термину Customer Network, а VM Subnet – термину Virtual Subnet. Действительно, если с помощью командлетов Get-SCVMNetwork и Get-SCVMSubnet получить информацию о созданных только что нами объектах, то в отклике первого командлета среди прочего вы увидите Routing Domain ID (RDID), а второго – Virtual Subnet ID (VSID).

Остается создать шаблоны ВМ для каждой сети, и на их основе можно будет развертывать требуемое количество «Синих» и «Красных» ВМ.

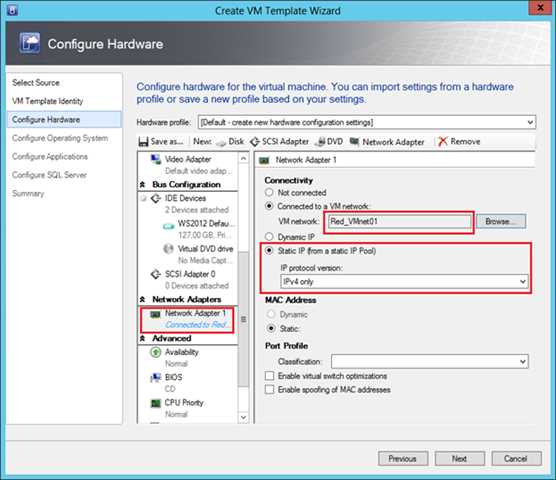

Создание шаблонов виртуальных машин (VM Template)

Процедура создания шаблонов для ВМ, которые будут использовать NV, совершенно стандартная и по сути ничем не отличается от создания шаблонов для любых других ВМ. Единственное, на что надо обратить внимание, что виртуальный сетевой адаптер подключен к нужной сети ВМ. Например, для шаблона «Красных» эта настройка выглядит следующим образом:

Параметр «Static IP» указывает VMM на то, что при создании ВМ по этому шаблону необходимо выделить статический IP-адрес из пула, связанного с сетью Red_VMnet01. А поскольку для этой сети включена технология NV, то выделенный адрес будет CA-адресом. Кроме того, в процессе развертывания виртуальной машины VMM выделит из пула, связанного с соответствующей логической сетью, PA-адрес, ассоциирует пару CA-адрес / PA-адрес и пропишет необходимые строчки в политику виртуализации того хоста, на котором будет развернута ВМ. Если в ЦОД-е используется динамическая адресация, то IP-адреса могут выделяться не из пулов VMM, а из скопов DHCP-сервера, и в этом случае в шаблоне ВМ необходимо выбрать параметр «Dynamic IP».

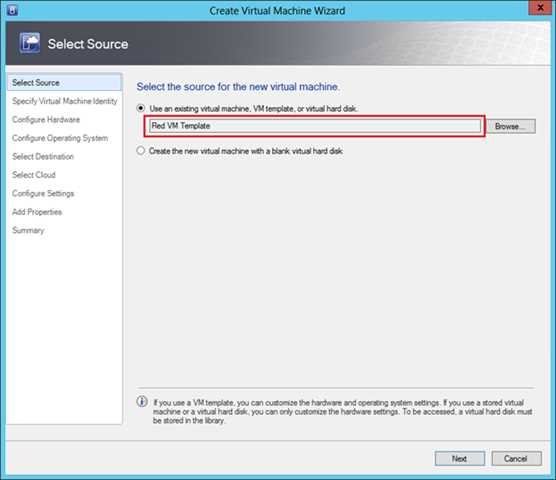

Развертывание ВМ с использованием подготовленных шаблонов

Теперь все полностью готово, и можно разворачивать ВМ на основе подготовленных шаблонов. Нажимаем кнопку «Create Virtual Machine» и выбираем нужный шаблон.

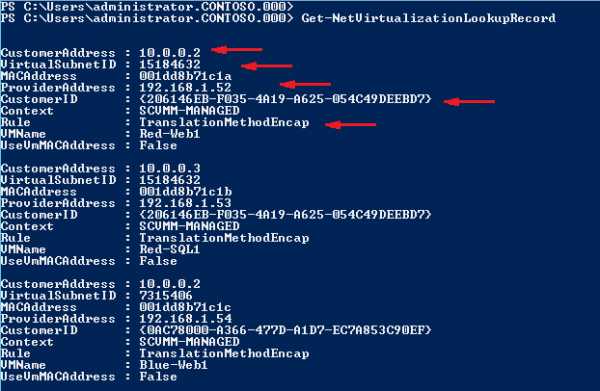

Давайте посмотрим, как выглядит отклик одного из упомянутых в начале поста командлетов в моей тестовой среде. Ниже фактически изображена политика виртуализации на одном из хостов:

В частности видно, что машине Red-Web1 был выделен CA-адрес 10.0.0.2 (первый доступный адрес в пуле) и ассоциирован с PA-адресом 192.168.1.52. ВМ принадлежит подсети с VSID=15184632 и относится к Customer Network с идентификатором RDID={206146EB-F035-4A19-A625-054C49DEEBD7}.

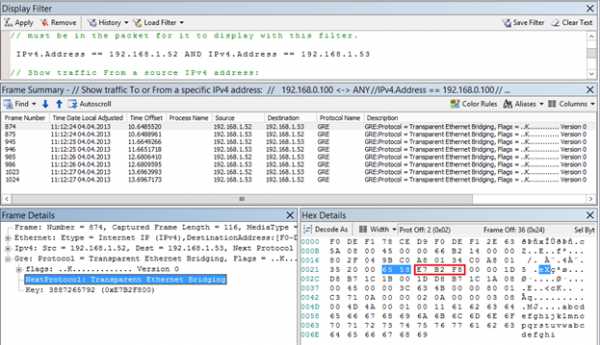

Еще один очень интересный параметр «Rule» со значением «TranslationMethodEncap» говорит о том, что для виртуализации IP-адресов используется механизм NVGRE. Этот механизм применяется по умолчанию при настройке NV в VMM и рекомендуется для большинства сценариев виртуализации сети. Можно проверить работу механизма инкапсуляции, сделав c машины Red-Web1 ping на адрес 10.0.0.3 и посмотрев сетевым монитором на структуру передаваемых пакетов.

Во-первых, можно наблюдать, что пинги передаются в виде GRE-пакетов между хостами с PA-адресами 192.168.1.52 и 192.168.1.53. Во-вторых, в заголовке GRE указано, что внутри лежит пакет некоторого протокола с номером 0x6558 (выделен на рисунке синим), каковым и является стандарт NVGRE. В-третьих, по спецификации NVGRE следующие 24 бита (обведены красным) содержат VSID. Действительно, если 0xE7B2F8 перевести в десятичный вид, получим VSID=15184632, что является подсетью «Красных».

Таким образом, мы настроили и выполнили проверку работоспособности технологии Hyper-V Network Virtualization. Однако пожалуй, это не более чем лабораторные испытания, поскольку мы не обеспечили взаимодействие ВМ с внешним миром. О том, как это выглядит с архитектурной точки зрения и как настраивается, поговорим в следующем посте.

А пока вы можете:

Надеюсь, материал был полезен.

Спасибо!

habr.com

10 советов по начальной настройке среды Hyper-V / Блог компании Veeam Software / Хабр

Как правило, установка среды Hyper-V не представляет собой ничего принципиально сложного и не занимает много времени. Однако, ее настройка может вызвать массу вопросов и точно потребует пристального внимания. Поэтому сегодня мы бы хотели дать несколько полезных советов по тому, как правильно выполнить настройку Hyper-V. Порядок их применения может быть произвольным.

1. Установите обновления, а затем решите, как будете обновлять Hyper-V в дальнейшем

Независимо от способа установки, компоненты на сервере Hyper-V необходимо будет обновлять, и вам нужно решить, как именно это делать. Обновления, требующие перезагрузки хоста, приостанавливают работающие на нем виртуальные машины и возобновляют их работу, как только хост будет снова запущен. Если такой вариант не приемлем, то следует обдумать возможности переноса виртуальной машины, использования SCVMM, выделения времени на обновления и т.д.

2. Определитесь с доменом

Есть различные точки зрения по поводу того, добавлять ли хосты Hyper-V в тот же домен Active Directory, где находится все остальное, или нет. Некоторые пользователи выделяют отдельный домен для хостов Hyper-V, другие даже не вводят хосты Hyper-V в домен. Оценить риски, рассмотреть особенности управления доменами и возможные сценарии сбоев, чтобы принять решение, лучше всего исходя из вашей оценки виртуальной среды, т.е, универсального ответа нет, и вам придется решить это самостоятельно. Кроме того, на этом этапе нужно придумать для хоста Hyper-V подходящее имя. Лучше подбирать имя, которое будет выделяться в номенклатуре ваших серверов, потому что ошибок при работе с хостом Hyper-V допускать нельзя: они могут быть по-настоящему губительны. Перепутать названия и пустить в перезагрузку хост с виртуальными машинами почтового и файлового серверов в разгар рабочего дня – не та ситуация, ради которой внедряют виртуализацию.

3. Настройте систему хранения

Если вам необходимы драйверы MPIO и НВА-адаптера или программное обеспечение для SAN, установите все это еще до того, как добавите роль Hyper-V (речь идет о сценарии установки для Windows Server 2012). К тому времени, когда вы займетесь виртуальными машинами, все эти компоненты уже должны быть в рабочем состоянии.

4. Настройте учетные записи администраторов

Хотите использовать тот же пул администраторов, что и на всех остальных серверах Windows Server? Тогда перечитайте пункт 2.

5.Подберите понятные имена для сетевых интерфейсов

Если вы правильно настроили виртуальную среду, на ваших хостах будет несколько сетевых интерфейсов. Когда все они называются «Подключение по локальной сети» или «Подключение по локальной сети 2», это не очень удобно. Хорошо, если у вас интерфейсы разных типов (например, на базе устройств Broadcom и Intel): можно просто вспомнить, что и где стоит. Но рассчитывать только на свою память не стоит. Присвойте каждому интерфейсу понятное имя: «ЛВС хоста», «ЛВС управления» и т. д. Можно даже указать тип канала связи: «К» для кабельных, «С» для сложносоставных и т. п.

6. Отключите ненужные протоколы

Если хосты Hyper-V будут работать в центре обработки данных, вы, скорее всего, не будете использовать большинство одноранговых сетевых технологий Windows, и тем более, протокол IPv6. Все должно быть предельно просто: стоит упростить инфраструктуру и отключить такие компоненты, как протокол IPv6, служба топологии канального уровня и вообще все, чем вы точно не будете пользоваться.

7. Обязательно активируйте Windows

Независимо от того, какой способ активации вы используете: сервер управления ключами (KMS), ключ многократной активации (MAK), OEM-версию Windows или что-то еще, — убедитесь в том, что загрузка Windows не прерывается из-за предложения активировать систему с помощью консоли. Этот момент не так важен при использовании Hyper-V Server 2012, бесплатного гипервизора от Microsoft.

8. Настройте удаленное и локальное управление

Это одна из рекомендаций Microsoft, которая необходима, но которую часто игнорируют. Новый диспетчер серверов, оболочка PowerShell и диспетчер Hyper-V позволяют выполнять многие операции в удаленном режиме, не входя непосредственно на сервер. Однако при этом необходимо подобрать для себя удобный инструмент. Например, некоторые по-прежнему предпочитают входить на серверы в режиме удаленного рабочего стола, даже если приходится использовать банальную консоль с одной-единственной командной строкой, как Windows Server Core с Hyper-V или Hyper-V Server 2012.

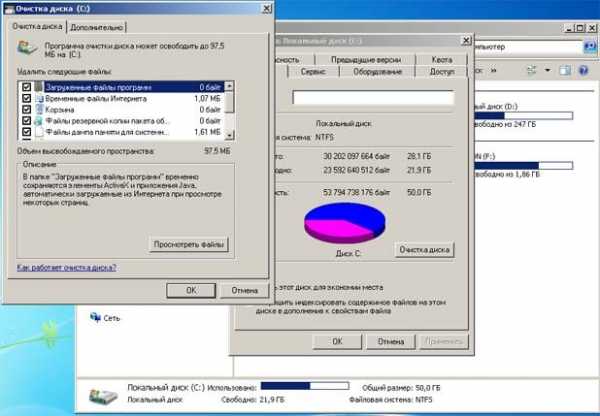

9. Задайте пути по умолчанию к виртуальным машинам и дискам

Что может раздражать сильнее, чем случайно наткнуться на виртуальную машину на локальном диске? Как ни странно, иногда такое случается из-за ошибок администрирования. Обязательно укажите правильное местоположение в настройках виртуальных жестких дисков и виртуальных машин. Можно не ждать ничего хорошего, если вы заполните диск C:\ и хост перестанет нормально работать, поэтому даже если приведенный вариант (диск E:\ на рисунке 2) не оптимален, в ситуации, когда диск переполняется, он все равно лучше.

10. Проверьте возможность доступа по внештатному каналу

Этот совет актуален как для Hyper-V, так и для vSphere. Убедитесь в том, что вы сможете подключиться к системе, если что-то пойдет не так. Вам помогут такие инструменты, как KVM, Dell DRAC или HP iLO.

Это советы самого общего характера, основанные на опыте работы с виртуальной средой, но наверняка есть масса других полезных приемов. На самом деле, лучший способ приобрести опыт — развернуть систему, а затем зафиксировать, что именно пришлось изменять после установки.

Чтобы настроенная система виртуализации продолжала в дальнейшем оптимально функционировать, можно применять средства резервного копирования, мониторинга и анализа производительности, специально предназначенные для виртуальной среды. Дополнительно на эту тему можно посмотреть следующие ссылки:

habr.com

Хата - Расскажите подробнее о Hyper-V

Краткое описание

Microsoft Hyper-V Server - это гипервизор, встроенный в Windows 2008 Server Core. За счет аппаратной виртуализации предоставляет гостевым системам прямой(!) доступ (т.е. без участия промежуточных виртуальных драйверов, замедляющих работу) к устройствам сервера (диск, память, процессор и т.д.). Официально поддерживает ОС Windows и Linux, на практике - любые ОС соответсвующей архитектуры (FreeBSD, OpenBSD работают без проблем).

Какие основные возможности Windows 2008 Hyper-V?

- Поддержка виртуальных сетей (Virtual LAN)

- Большой объем памяти для виртуальных машин

- Возможность одновременного запуска 32-х битных и 64-х битных машин

- До 32GB RAM и 4 CPU для каждой OS

- Поддержка одного или нескольких процессоров для виртуальных машин

- Поддержка точек восстановления, использующихся для фиксации состояния виртуальной машины в определенные моменты времени. Вы можете вернуться к любой точке восстановления в любое время

- Поддержка быстрой миграции, которая позволяет вам переместить виртуальную машину с одного сервера на другой, без выключения этой виртуальной машины,

- Поддерживается балансирование нагрузки сети между виртуальными машинами

- Интеграция с менеджером Microsoft Virtual Machine Manager (VMM), в качестве основной платформы.

А если копнуть глубже...

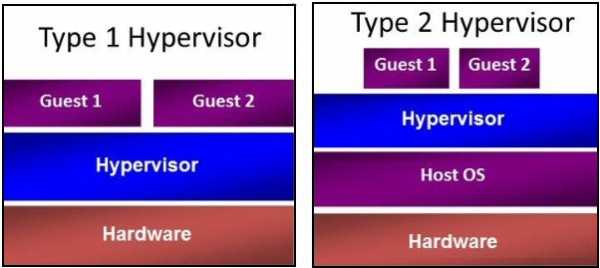

Типы решений виртуализации

По сути, существуют три основных вида архитектур, используемых для виртуализации серверов, как показано на рис. 1. Фундаментальные отношения между ними лежат в области отношений между уровнем виртуализации и физическим оборудованием. Под уровнем виртуализации я понимаю уровень программного обеспечения, именуемый монитором виртуальных компьютеров (VMM, не путать с Virtual Machine Manager). Именно этот уровень предоставляет возможность создавать несколько изолированных экземпляров на основе одних и тех же аппаратных ресурсов.

Рис 1. Три архитектуры виртуализации

Примером архитектуры VMM типа 2 являются виртуальные компьютеры Java Virtual Machines. Здесь целью виртуализации является создание среды выполнения, внутри которой процесс сможет выполнять набор инструкций, не полагаясь на систему-носитель. В данном случае, изоляция предназначена для различных процессов и позволяет одному приложению работать на различных ОС, не заставляя беспокоиться насчет зависимостей ОС. Виртуализация серверов не попадает в эту категорию.

VMM типа 1 и гибридные VMM — это подходы, с использованием которых обычно можно столкнуться сегодня. Гибридная VMM — это этап, на котором VMM запущена вместе с ОС хост-компьютера и помогает создать виртуальные машины. Примерами гибридных VMM являются Microsoft Virtual Server, Microsoft Virtual PC, VMware Workstation и VMware Player. Следует отметить, что хотя эти типы решений отлично подходят для сценариев клиентов, где виртуальные компьютеры используются лишь в течении части времени, VMM также добавляют существенные системные издержки и, следовательно, не подходят для рабочих нагрузок, интенсивно использующих ресурсы.

В архитектуре VMM типа 1, уровень VMM работает прямо над оборудованием. Это часто называется уровнем гипервизора. Эта архитектура была первоначально разработана IBM в 1960-е годы для мэйнфреймов и недавно стала доступной на платформах x86/x64, как часть ряда решений, включая Windows Server 2008 Hyper-V.

Существуют доступные решения, на которых гипервизор является внедренной частью микропрограммного обеспечения. Это, однако, является лишь вариантом поставки и не влияет на технологию как таковую.

Глядя на VMM типа 1 можно обнаружить, по сути, два основных вида архитектуры решений гипервизора: микроядерную и монолитную. Оба этих подхода, как показано на рис. 2, являются настоящими VMM типа 1, у которых гипервизор установлен прямо на физическое оборудование.

Рис. 2. Две модели архитектуры решений гипервизора

Монолитный подход размещает гипервизор/VMM в едином уровне, который также включает большинство требуемых компонентов, таких как ядро, драйверы устройств и стек ввода/вывода. Это подход, используемый такими решениями, как VMware ESX и традиционные системы мэйнфреймов.

Микроядерный подход использует очень тонкий, специализированный гипервизор, выполняющий лишь основные задачи обеспечения изоляции разделов и управления памятью. Этот уровень не включает стека ввода/вывода или драйверов устройств. Это подход, используемый Hyper-V. В этой архитектуре стек виртуализации и драйверы конкретных устройств расположены в специальном разделе, именуемом родительским разделом.

Архитектура Windows Server Hyper-V

Функция Hyper-V, которая должна была составить конкуренцию Vmware ESX Server, изначально создавалась на основе новой микроядерной архитектуры. На рис. 3. показана архитектура Server 2008 Hyper-V.

Рис. 3. Архитектура Server 2008 Hyper-V

В отличие от модели виртуализации на базе хоста Virtual Server, которая требовала запуска функции виртуализации поверх операционной системы компьютера, Hyper-V представляет собой виртуальную среду, работающую непосредственно на аппаратном уровне, без обменов с операционной системой компьютера. Архитектура Hyper-V состоит из гипервизора микроядра, а также родительских и дочерних разделов.

Все версии Hyper-V имеют один родительский раздел. Этот раздел управляет функциями Hyper-V. Из родительского раздела запускается консоль Windows Server Virtualization. Кроме того, родительский раздел используется для запуска виртуальных машин (VM), поддерживающих потоковую эмуляцию старых аппаратных средств. Такие VM, построенные на готовых шаблонах, эмулирующих аппаратные средства, являются аналогами VM, работающих в продуктах с виртуализацией на базе хоста, например Virtual Server.

Гостевые VM запускаются из дочерних разделов Hyper-V. Дочерние разделы поддерживают два типа VM: высокопроизводительные VM на основе архитектуры VMBus и VM, управляемые системой-хостом. В первую группу входят VM с системами Windows Server 2003, Windows Vista, Server 2008 и Linux (поддерживающими Xen). Новую архитектуру VMBus отличает высокопроизводительный конвейер, функционирующий в оперативной памяти, соединяющий клиентов Virtualization Service Clients (VSC) на гостевых VM с провайдером Virtual Service Provider (VSP) хоста. VM, управляемые хостом, запускают платформы, не поддерживающие новую архитектуру VMBus: Windows NT, Windows 2000 и Linux (без поддержки технологии Xen, например SUSE Linux Server Enterprise 10).

Дополнительная информация

vds.data-xata.com

Hyper-V или KVM? / Блог компании RUVDS.com / Хабр

Технология виртуализации серверов со своей более чем тридцатилетней историей сегодня стала одной из ключевых в ИТ, легла в основу облачных вычислений и сервисов нового поколения. Компании, выбирающие платформу для VPS или внедрения виртуализации в своей ИТ-инфраструктуре, наряду с продуктами VMware рассматривают в качестве альтернативы решения на основе других гипервизоров, прежде всего Microsoft Hyper-V и разработанного в рамках Open Source гипервизора KVM.Разнообразие средств виртуализации заставляет задуматься: что именно выбрать? Это может оказаться непростой задачей. Например, сторонники Xen считают ее надежной и гибкой платформой с хорошим набором инструментов управления. Любители Hyper-V и KVM приведут весомые аргументы в пользу этих решений и перечислят их достоинства.

Можно исходить при выборе из таких параметров как производительность, стоимость, открытость, эффективность, управляемость, поддержка платформ… Однако эксперты советуют выбирать решение виртуализации, прежде всего, руководствуясь требованиями бизнеса. Развертываемое в корпоративной среде, оно должно подходить для обширного стека сертифицированных бизнес-приложений (ERP, MRP, HR, CRM и др.), а разработчик, если это коммерческий продукт, должен иметь четкие планы развития продукта по разным направлениям (аварийное восстановление, резервное копирование, SDN и др.). Наконец, хорошее программное обеспечение виртуализации обладает достаточной масштабируемостью и гибкостью.

Можно исходить при выборе из таких параметров как производительность, стоимость, открытость, эффективность, управляемость, поддержка платформ… Однако эксперты советуют выбирать решение виртуализации, прежде всего, руководствуясь требованиями бизнеса. Развертываемое в корпоративной среде, оно должно подходить для обширного стека сертифицированных бизнес-приложений (ERP, MRP, HR, CRM и др.), а разработчик, если это коммерческий продукт, должен иметь четкие планы развития продукта по разным направлениям (аварийное восстановление, резервное копирование, SDN и др.). Наконец, хорошее программное обеспечение виртуализации обладает достаточной масштабируемостью и гибкостью.

Например, производительность KVM при увеличении нагрузки уменьшается быстрее, чем у Xen (если верить результатам тестирования). Xen отличает масштабируемость – способность поддерживать большое число одновременно работающих ВМ. Считается, что Xen превосходит KVM по возможностям резервного копирования и управления хранением данных.

Подобная дилемма возникает и при анализе предложений по аренде виртуальных серверов (VDS/VPS). Хостеры предлагают разнообразные средства виртуализации, включая Xen, KVM, Microsoft Hyper-V, OpenVZ, Virtuozzo, VDSmanager и др. (VMware – очень редко ввиду высокой стоимости), при этом провайдер всегда готов рассказать о достоинствах используемой системы, но продукты виртуализации редко сравнивают и столь же редко упоминают об их недостатках.

Попробуем отчасти восполнить этот пробел. В частности — сопоставить два популярных гипервизора виртуализации – Microsoft Hyper-V для серверных ОС семейства Windows и KVM для Linuх. Однако сразу стоит оговориться, что идеальной системы виртуализации для VPS нет, каждая подходит для своих задач. Например, многие из тех, кто использует платформу KVM, применяют и виртуальные машины (ВМ) на базе Linux.

Нужен VPS c Linux или FreeBSD? Можно выбрать KVM. VPS на KVM с Windows – тоже вариант, но для данной ОС предпочтительнее Microsoft Hyper-V. Последний считается лучшим решением для виртуализации серверов с ОС Windows, и активно используется хостинг-провайдерами.

Нужен VPS c Linux или FreeBSD? Можно выбрать KVM. VPS на KVM с Windows – тоже вариант, но для данной ОС предпочтительнее Microsoft Hyper-V. Последний считается лучшим решением для виртуализации серверов с ОС Windows, и активно используется хостинг-провайдерами.Xen и KVM – продукты с открытым исходным кодом, причем очень близкие по функциям и производительности, но если в версии Сitrix XenServer первый постепенно превращается в облачную платформу, то развитие KVM идет в ногу с эволюцией дистрибутивов, таких как RHEV от Red Hat. Hyper-V — коммерческое ПО от Microsoft. Не удивительно, что Hyper-V отлично работает в инфраструктуре Windows. Все они позволяют виртуализировать серверные платформы x86-64 и представляют собой системы аппаратной виртуализации для VPS хостинга и не только.

Hyper-V, KVM, ESXi – гипервизоры первого типа (Type-I). Они работают непосредственно на физическом оборудовании, к которому операционная система получает доступ через гипервизор. Гипервизоры второго типа (Type-II), например, VMware Workstation, Oracle Virtual Box, OpenVZ функционируют поверх операционной системы, поэтому ВМ и гипервизор взаимодействует с оборудованием через ОС. Считается, что производительность гипервизоров второго типа ниже, чем первого, поскольку зависит также от ОС хоста.

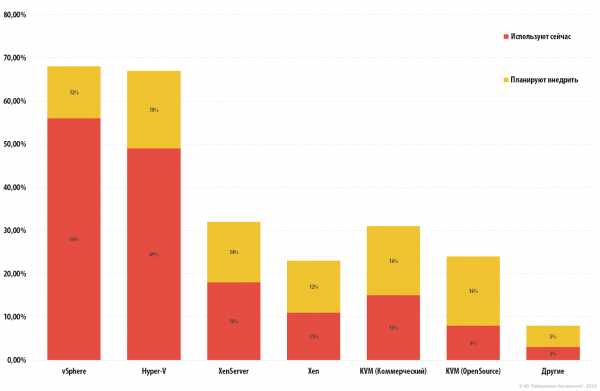

Hyper-V, KVM, ESXi – гипервизоры первого типа (Type-I). Они работают непосредственно на физическом оборудовании, к которому операционная система получает доступ через гипервизор. Гипервизоры второго типа (Type-II), например, VMware Workstation, Oracle Virtual Box, OpenVZ функционируют поверх операционной системы, поэтому ВМ и гипервизор взаимодействует с оборудованием через ОС. Считается, что производительность гипервизоров второго типа ниже, чем первого, поскольку зависит также от ОС хоста.Использование Hyper-V и KVM в разных отраслях, % респондентов (данные IT Central Station).

| Гипервизор | Hyper-V | KVM |

| Финансы | 13% | 21% |

| Транспорт | 9% | 11% |

| Производство | 7% | 7% |

| Госсектор | 7% | 7% |

| Гипервизор | Hyper-V | KVM |

| 1-100 | 17% | 25% |

| 100-1000 | 34% | 30% |

| >1000 | 49% | 45% |

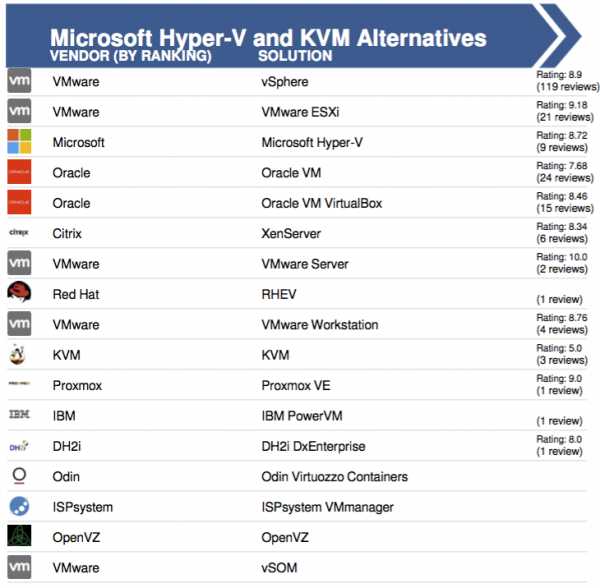

Альтернативы Hyper-V и KVM (в версии Open Source), по мнению отраслевой прессы (в порядке убывания; рейтинг составлен IT Central Station, 2016 год).

Альтернативы Hyper-V и KVM (в версии Open Source), по мнению отраслевой прессы (в порядке убывания; рейтинг составлен IT Central Station, 2016 год).Microsoft Hyper-V

Продукт Microsoft существует в двух ипостасях: как автономный Hyper-V Server (в последней версии — Hyper-V Server 2012 R2) или как один из компонентов Windows Server 2008, Windows Server 2008 R2, Windows Server 2012, Windows Server 2012 R2 или 64-разрядной версии Window 8/10 Pro. В любом случае он используется для создания на сервере виртуальной среды, предоставляя для этого соответствующие сервисы и инструменты.Можно также виртуализировать рабочие места, развернув инфраструктуру VDI, или создать удобную среду для разработки и тестирования ПО. Экономичная и стабильная среда виртуализации Hyper-V позволяет одновременно запускать на хосте несколько операционных систем, включая Windows, Linux и другие. На текущий момент Hyper-V используют компании и организации практически любых отраслей, в их числе крупнейшие заказчики. Что это дает? Например, Hyper-V может служить основой для развертывания частного облака, позволяет оптимизировать использование аппаратных ресурсов, консолидировать серверы, запустив на одной физической системе несколько виртуальных машин, обеспечить отказоустойчивость для непрерывности бизнес-процессов. Впрочем, это свойственно не только данному гипервизору.

В «магическом квадранте» Gartner по виртуализации серверной инфраструктуры х86 (Magic Quadrant for x86 Server Virtualization Infrastructure), выпущенном в июле 2015 года, лидируют Micrоsoft и VMware. Xen и KVM представлены вендорами Citrix и Red Hat.